| Рубрикатор |  |

|

| Статьи |  |

ИКС № 2 2020 |  |

|

| Александр БАРСКОВ | 28 июня 2020 |

Охлаждение ЦОДа: погружение неизбежно

Ни рекордно низкий PUE, ни возможность многократного повышения мощности стойки не подвигли ЦОДы на использование жидкостного охлаждения. Однако неминуемый рост энергопотребления микропроцессоров заставит их обратить внимание на такие системы.

Жидкостное охлаждение – это не последний писк ИТ-моды, а самая что ни на есть классика, которой как минимум полвека. Первые системы жидкостного охлаждения появились в 60-х годах прошлого века вместе с мейнфреймами IBM System/360. Это была основная технология охлаждения, применявшаяся в вычислительных центрах тех времен. Заказчики доверяли жидкостному охлаждению, которое использовали для ИТ-систем, обслуживающих критически важные приложения.

Что же случилось с жидкостным охлаждением потом? Постепенно рынок завоевали относительно недорогие и маломощные серверы; они стали доминировать и в вычислительных центрах, которые во второй половине 90-х все чаще стали именовать центрами обработки данных, или дата-центрами. Для охлаждения не слишком энергозатратных микросхем таких серверов вполне хватало воздушного охлаждения – на процессоры устанавливали радиаторы и вентиляторы, как в обычных ПК. Более дорогое жидкостное охлаждение было практически забыто, его продолжали использовать разве что для суперкомпьютеров и кластеров высокопроизводительных вычислений (High Performance Computing, HPC).

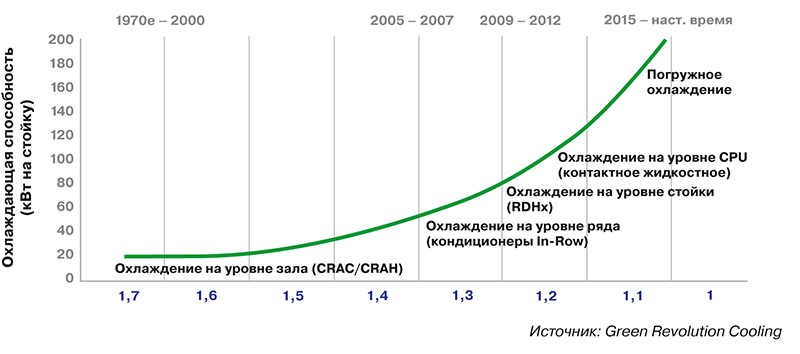

Типовое решение для отвода тепла от ИТ-оборудования современных ЦОДов – воздушное охлаждение. Для этого задействуются либо шкафные (CRAH/CRAC), либо внутрирядные кондиционеры, подающие холодный воздух к ИТ-оборудованию. Такие кондиционеры обычно используются, когда тепловая нагрузка на стойку составляет порядка 5 кВт. За счет изоляции воздушных потоков (коридоров) и ряда других специальных мер теплоотвод с одной стойки можно увеличить до 20 кВт. Но, по сути, это максимум, на который способны системы воздушного охлаждения. При увеличении плотности мощности охлаждение воздухом становится либо технически невозможным, либо экономически неоправданным.

Таксономия жидкостного охлаждения

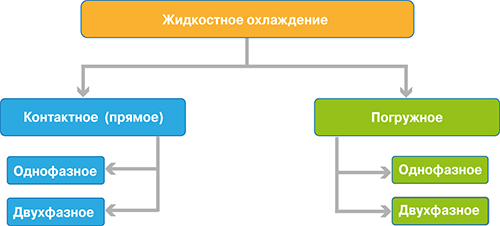

Множество различных способов жидкостного охлаждения можно разделить на две основные группы в зависимости от того, находится ли жидкость в прямом физическом контакте с охлаждаемой электроникой или нет (рис. 1). Если жидкость не контактирует непосредственно с электроникой, то такие технологии охлаждения, как бы это ни казалось странно, называют контактными (conductive), если контактирует – то погружными (immersive). В системах первого типа обычно используют проводящие жидкости, например воду или ее растворы, в системах второго – диэлектрические жидкости: минеральные, синтетические масла или специальные инженерные жидкости.

Рис. 1. Классификация систем жидкостного охлаждения

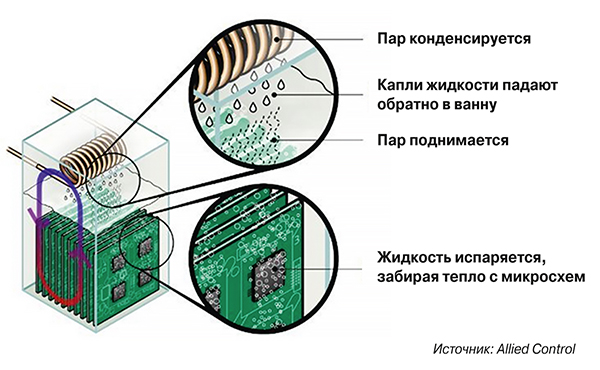

Другой критерий классификации технологий жидкостного охлаждения основывается на том, претерпевает ли жидкость фазовый переход в процессе передачи ей тепла. Если фазового перехода не происходит, то технологию называют однофазной, если происходит, скажем, жидкость испаряется (рис. 2) – двухфазной. Вода и масла – однофазные охлаждающие жидкости. Многие хладагенты (например, R-134a) и некоторые инженерные жидкости (например, 3M Novec 7100) – это двухфазные хладагенты. Контактные и погружные технологии могут быть как однофазными, так и двухфазными.

Рис. 2. Принцип организации двухфазной системы погружного охлаждения на примере решения Allied Control (используется жидкость 3M Novec 7100)

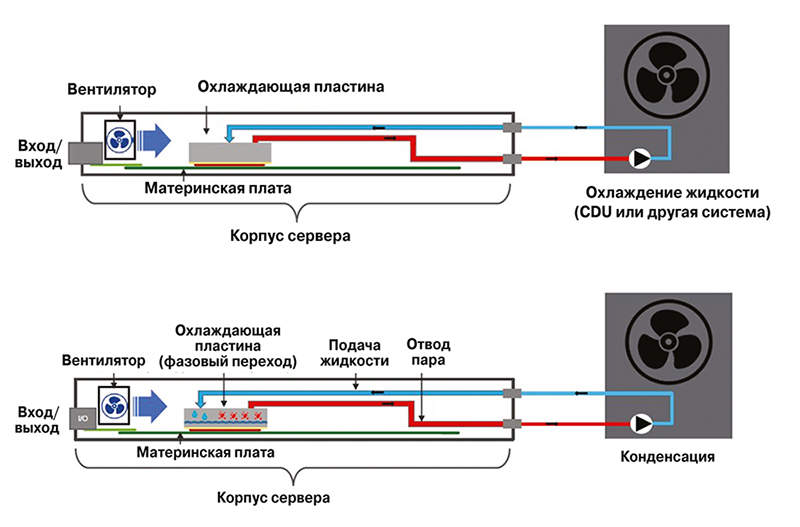

Часто говорят о прямом (direct) жидкостном охлаждении. В этом случае имеют в виду контактное охлаждение, когда тепло электронных компонентов передается жидкости без привлечения воздуха. Пример такого решения – теплоотвод с помощью охлаждающей пластины, которая через термопасту присоединена к CPU (рис. 3). Прямое жидкостное охлаждение может использоваться для теплосъема с других электронных компонентов, в первую очередь оперативной памяти, контроллеров памяти и элементов системы электропитания. Важно не путать прямое (контактное) охлаждение с погружным: слово «прямой» здесь описывает непосредственную (прямую) передачу тепла жидкости, а не нахождение жидкости в прямом (физическом) контакте с электроникой.

Источник: Schneider Electric

Рис. 3. Прямое (контактное) однофазное (вверху) и двухфазное (внизу) жидкостное охлаждение

В качестве альтернативы прямому жидкостному охлаждению может применяться и гибридное (непрямое) охлаждение. В этом случае тепло снимается с активных компонентов ИТ-оборудования воздухом с помощью традиционных средств, таких как воздушный радиатор. Затем нагретый воздух охлаждается в теплообменниках «воздух – жидкость», которые могут быть установлены как внутри серверов, так и за их пределами. Примером теплообменников «воздух – жидкость», которые располагаются вне серверов, являются так называемые холодные двери (Rear-Door Heat Exchanger, RDHx): в заднюю часть (дверь) монтажной стойки монтируется теплообменник, который, в свою очередь, подключается к трубопроводу с холодной водой чиллерной системы охлаждения здания.

Во многих случаях задействовать прямое жидкостное охлаждение для всех электронных компонентов в ИТ-оборудовании нецелесообразно или просто невозможно. Поэтому оставшаяся часть тепла (как правило, основная доля тепла отводится с помощью жидкостного охлаждения) выводится традиционными воздушными системами охлаждения. Этот смешанный режим охлаждения называют комбинированным воздушно-жидкостным охлаждением. Например, прямое жидкостное охлаждение может использоваться только для микропроцессоров, а традиционное воздушное охлаждение – для остальной электроники.

Во всех описанных выше способах охлаждения – прямого, гибридного и комбинированного – жидкость не находится в непосредственном физическом контакте с электронными компонентами. Далее в статье речь пойдет о более эффективных технологиях погружного охлаждения, когда жидкость находится в непосредственном контакте с электроникой.

Рис. 4. Решение, в котором серверы опускаются в ванну с охлаждающей жидкостью (система однофазного погружного охлаждения DTL)

Погружное охлаждение реализуется двумя основными способами. Первый – когда все устройство (сервер) погружается в резервуар (ванну) с диэлектрической жидкостью (рис. 4). В таком резервуаре, фактически лежащей горизонтально стойке, можно разместить до 42 серверных юнитов.

Второй вариант – размещение каждого вычислительного модуля в отдельном герметичном корпусе, заполняемом охлаждающей жидкостью. Такие серверы можно устанавливать в вертикальные стойки (рис. 5), для которых требуется меньше площади, чем для горизонтальных резервуаров.

Рис. 5. Стойка с серверами, каждый из которых размещен в герметичном корпусе, заполненном охлаждающей жидкостью

В обоих вариантах погружных систем с помощью жидкости снимается 100% тепла, дополнительного (воздушного) охлаждения не требуется.

Время пришло!

Плотность мощности ИТ-оборудования постоянно повышается, а возможности систем воздушного охлаждения близки к своему пределу. Для отвода тепла от наиболее тепловыделяющих компонентов – CPU, графических процессоров (GPU), памяти – требуются все большие объемы холодного воздуха, генерация и доставка которого становятся все более затратными. Более того, компоненты не только генерируют больше тепла, их число на единицу площади также увеличивается. На пути воздушного потока возникают все новые препятствия, для преодоления которых нужно увеличивать мощность вентиляторов. Кроме того, электронные компоненты, находящиеся в задней части сервера, заслоняются теми, что расположены спереди, – воздух до них доходит уже нагретый элементами, которые установлены ближе к входным вентиляционным отверстиям (вентиляторам).

Флагманские CPU и GPU ведущих производителей – Intel, AMD, Nvidia – уже давно преодолели уровень требований к теплоотводу (Thermal Design Power, TDP) в 200–300 Вт. И этот уровень постоянно растет. Так, анонсированные весной 2019 г. процессоры Platinum 9282 старшей линейки Xeon Platinum имеют TDP 400 Вт. С учетом установки нескольких процессоров в сервер высотой 1U получаем, что тепловыделение в расчете на 1U легко может составить несколько киловатт, а полностью заполненной стойки – 40–80 кВт.

Как уже говорилось, используя обычные методы воздушного охлаждения, практически невозможно отводить от стандартной ИТ-стойки более 20 кВт тепла. Для систем жидкостного охлаждения 20 кВт на стойку – далеко не предел. В настоящее время существуют системы, способные «снимать» 100 кВт, а некоторые – 200 кВт и более (в пересчете на типовую ИТ-стойку).

У внимательного читателя, наверное, возникнет вопрос: а зачем «запихивать» столько высокоплотной электроники в одну стойку, когда можно «разбросать» энергоемкие процессоры по нескольким стойкам, сохранив мощность каждой в пределах 20 кВт. Дело в том, что современные приложения, например искусственного интеллекта и анализа больших данных, требуют низкой задержки взаимодействия между процессорами и другими активными элементами. А значит, разносить на большие расстояния (даже по соседним стойкам) решающие одну задачу процессоры нежелательно.

Преимущества погружного охлаждения

Теплопередающие свойства жидкости обеспечивают на несколько порядков более эффективный отвод тепла от электронных компонентов. Жидкостное охлаждение позволяет плотнее размещать мощные процессоры и другие компоненты, а для отвода тепла от них требуется меньше энергии.

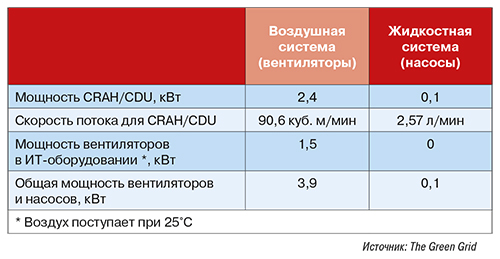

Расчет, проведенный экспертами The Green Grid, показывает следующее: чтобы устройство мощностью 1 кВт охладить на 11˚C, потребуется поток воздуха 4474 л/мин или же расход воды всего 1,29 л/мин. Эксперты сравнили охлаждение стойки мощностью 20 кВт с помощью систем классического воздушного охлаждения и водяного охлаждения. Оказалось, что жидкостная система израсходует электричества примерно в 40 раз меньше (табл. 1).

Табл. 1. Сравнение энергопотребления для охлаждения стойки 20 кВт (без учета чиллерной системы)

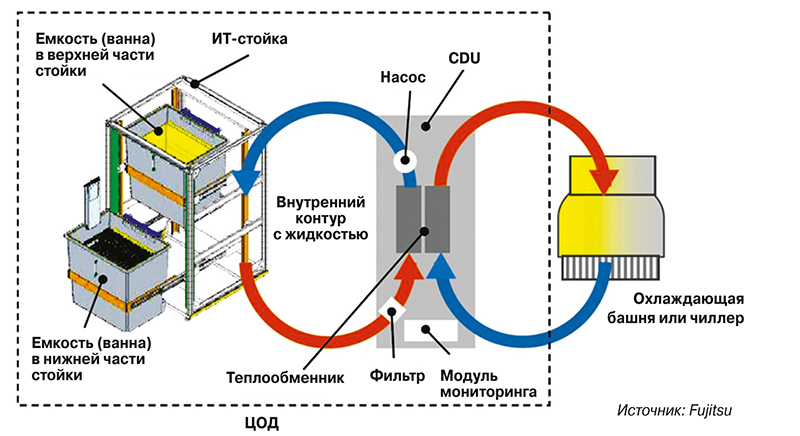

В табл. 1 в расчет не бралась внешняя чиллерная система (или другая система, обеспечивающая охлаждение воздуха или жидкости, циркулирующей во внешнем контуре серверного зала). Система воздушного охлаждения серверного зала взаимодействует с такой системой через теплообменник «воздух – жидкость» в кондиционере CRAH. А система жидкостного охлаждения – через теплообменник «жидкость – жидкость» в распределительном блоке (CDU) (рис. 6). Как правило, CDU размещают непосредственно в конструктиве, где установлена и емкость с охлаждающей жидкостью.

Рис. 6. Интеграция системы погружного охлаждения (Fujitsu Liquid Immersion Cooling System) через блок CDU с внешним контуром охлаждения, подключенным к чиллеру или охладительной башне (драйкулеру)

В табл. 2 приведено энергопотребление сравниваемых систем охлаждения с учетом чиллерной системы. Также показан расход электричества для гибридной системы, когда 50% тепла с ИТ-оборудования снимается воздушной системой, а 50% – жидкостной.

Табл. 2. Сравнение энергопотребления для охлаждения стойки 20 кВт с учетом энергии, потребляемой чиллерной системой

Обратите внимание на то, какой расход воздуха (90,6 куб. м/мин) необходим для снятия 20 кВт тепла со стойки. Такой объем непросто обеспечить в серверных залах с типовым фальшполом, используемым в качестве воздуховода для подачи холодного воздуха к стойкам. Для этого потребуется создать высокое статическое давление воздуха в пространстве под фальшполом. Тогда как установить насос мощностью 100 Вт для прокачки 2,57 л охлаждающей жидкости в минуту совсем несложно.

Следует также заметить, что ввиду высокой эффективности систем жидкостного охлаждения они могут обеспечивать эффективный отвод тепла от электроники даже при высоких температурах охладителя: 45˚C и выше. Это позволяет отказаться от энергозатратных чиллерных систем, используя для охлаждения жидкости внешние системы естественного охлаждения окружающим воздухом, например, охладительные башни или сухие градирни.

В целом использование систем погружного охлаждения обеспечивает рекордно низкие показатели коэффициента энергоэффективности PUE (рис. 7).

Рис. 7. Эволюция систем охлаждения ЦОДов и снижение коэффициента PUE

В дополнение к очевидным преимуществам существенной экономии места и энергии, погружное охлаждение позволяет также улучшить производительность и надежность работы ИТ-оборудования.

Более высокая производительность напрямую связана с более плотным размещением компонентов. Снижение задержки обусловлено как более короткими расстояниями между компонентами внутри сервера (стойки), так и улучшенной общей пропускной способностью сети за счет меньших расстояний для подключения стойки к стойке и стойки к ядру сети ЦОДа.

Кроме того, нужно учитывать следующее: как только температура процессора повышается до максимально допустимой, его производительность необходимо снизить, чтобы избежать отказа из-за перегрева. Для работы с максимальной производительностью, что важно, в частности, для систем HPC, требуется, чтобы температура процессора и памяти оставалась низкой. Погружное охлаждение позволяет плотно упакованным системам работать непрерывно при максимальной тактовой частоте, избегая перегрева.

Поскольку жидкость имеет гораздо большую термическую массу (т.е. способность сохранять температуру при изменении внешних условий) по сравнению с воздухом, температура охлаждаемых с помощью жидкости компонентов более стабильна, что повышает надежность их работы. Кроме того, при погружном охлаждении нет потребности в вентиляторах. Это уменьшает или полностью устраняет вибрации, которые могут оказать негативное влияние на работу вращающихся дисков, а также на другие операции, например, на функционирование разъемных соединений в местах подключения коннекторов. Вибрации, возникающие при работе вентиляторов, могут вызвать ошибки чтения-записи во вращающихся дисках, что значительно снижает производительность операций ввода-вывода.

Решения, представленные на российском рынке

Основные игроки на мировом рынке систем погружного охлаждения – это американские (Green Revolution Cooling, LiquidCool Solutions, Midas Green Technologies), японские (Fujitsu, ExaScaler) и голландские (Asperitas, DownUnder GeoSolutions) компании, а также Submer Technologies (Испания), Allied Control (Гонконг), Iceotope Technologies (Великобритания), DCX (Польша) и Horizon Computing Solutions (Франция).

Однако большинство ведущих мировых производителей систем погружного охлаждения слабо представлены в России. В случае американских вендоров, даже при наличии у них российских партнеров (они есть, в частности, у LiquidCool Solutions), сложная международная обстановка и санкции серьезно затрудняют поставку их продукции российским заказчикам.

На нашем рынке давно работает японская Fujitsu, которая известна прежде всего как производитель серверов и систем хранения данных. Наличие в портфеле продуктов этой компании собственного, в том числе подготовленного для погружного охлаждения, ИТ-оборудования является ее серьезным конкурентным преимуществом как поставщика комплексных решений. Так, Fujitsu Liquid Immersion Cooling System представляет собой однофазную систему с жидкостью 3M Fluorinert, которая комплектуется серверами и СХД PRIMERGY мощностью до 60 кВт на стойку (см. рис. 6). Публичных кейсов по поставкам систем Fujitsu Liquid Immersion Cooling System в Россию нет, но известно об инсталляции в нескольких корпоративных ЦОДах.

Компания 3M активно продвигает на российском рынке технологии двухфазного погружного охлаждения с использованием негорючей неэлектропроводной фторсодержащей жидкости Novec 7100 (см. рис. 2). Построенные на базе этой жидкости системы предлагают как зарубежные поставщики (например, Allied Control), так и российские компании (TGE Group и Immersium). Российские партнеры изначально ориентировались на оборудование для майнинга, однако в настоящее время готовят решения для ЦОДов.

В уже реализованных проектах применение погружного охлаждения на основе жидкости 3M Novec 7100 обеспечивает отвод тепла до 3,5 кВт на 1U, при этом потенциал технологии – до 10–20 кВт. Одним из самых известных проектов с использованием двухфазного погружного охлаждения на базе 3M Novec являются дата-центры BitFury Group, ведущего провайдера блокчейн-технологии. В них установлены системы охлаждения компании Allied Control (которая сегодня принадлежит BitFury Group).

На российском рынке активны и отечественные производители систем погружного охлаждения, предлагающие однофазные решения на базе жидкости собственной разработки. Так, компания DTL (специальный проект компании «Термосистемы») использует в своих системах диэлектрическую жидкость Cristallflow Dielectric. Серверное оборудование размещается в горизонтальных стойках (см. рис. 4), которые рассчитаны на мощность до 100 кВт.

Летом 2019 г. DTL объявила о запуске в эксплуатацию своего ЦОДа, использующего погружное охлаждение. Как заявляют в компании, это не только полностью коммерческий проект, но и демонстрационная площадка для знакомства всех заинтересованных предприятий, планирующих строительство или модернизацию дата-центров и серверных.

Рис. 8. Офисный вариант системы погружного охлаждения Liquid Cube

Liquid Cube – проект компании «Инпро Технолоджис» – представляет собой систему однофазного погружного охлаждения также на базе жидкости собственной разработки (рис. 8). Компания готова предложить «кубы» различного размера, при этом имеющееся решение на 23U обеспечивает теплоотвод 30 кВт – получается около 60 кВт в пересчете на типовую серверную стойку. Компания работает как с российскими, так и с зарубежными производителями серверного и другого ИТ-оборудования. Представители «Инпро Технолоджис» заверяют, что при достаточном объеме заказа вопрос сохранения гарантии на оборудование будет решен. Ряд зарубежных производителей сетевого оборудования уже обещали сохранить гарантию на свои решения при их работе в емкости с охлаждающей жидкостью Liquid Cube. Две системы Liquid Cube установлены в ЦОДе ФСК ЕЭС, но используются пока в тестовом режиме.

Рис. 9. МикроЦОД «Иммерс» на базе системы погружного охлаждения

Еще одну отечественную систему однофазного погружного охлаждения предлагает компания «Иммерс», входящая в ГК «Сторус». Само решение (рис. 9) было разработано совместно с Институтом программных систем им. А.К. Айламазяна РАН. Компания «Иммерс» имеет более чем восьмилетнюю историю поставок высокопроизводительных вычислительных систем на основе погружного охлаждения на объекты Минобороны, МВД, Объединенной самолетостроительной компании, Авиационного комплекса им. С.В. Ильюшина, ТАНТК им. Бериева, Казанского авиазавода и т.д. (всего поставлено более 100 систем). Компания выпускает и серийные продукты, которые могут размещаться в ЦОДах. В решениях используется зарубежная и отечественная элементная база AMD, Intel, Nvidia, МЦСТ («Эльбрус»), «Норси-Транс» («Яхонт») и других производителей, с которыми возможно заключить соглашения о сохранении гарантии на серверы и отдельные модули.

Динамика роста…

По данным MarketsandMarkets Research, в 2019 г. мировой рынок систем погружного охлаждения составил $177 млн. По прогнозу аналитиков, в ближайшие годы этот рынок будет расти в среднем на 23,2% в год и к 2024 г. достигнет порядка $500 млн. Главными драйверами его роста в MarketsandMarkets Research считают увеличение плотности как микросхем, так и ИТ-оборудования в стойках, появление новых областей применения дата-центров, в частности развертывания вблизи источников/потребителей данных edge-ЦОДов, а также необходимость сократить расход электроэнергии на охлаждение ИТ-комплексов.

При этом рынок систем охлаждения для ЦОДов в целом до 2021 г. будет увеличиваться на 15%, а его ожидаемый объем к этому времени составит $14,28 млрд. Даже при самых высоких темпах роста сегмент погружного охлаждения в 2021 г. займет лишь порядка 2% рынка систем охлаждения для ЦОДов. Очень скромный показатель!

…и препятствия на его пути

Так почему же при всех своих многочисленных преимуществах системы погружного охлаждения пока не получили широкого применения, а используются в основном в единичных проектах для охлаждения суперкомпьютеров и HPC-систем?

Основное препятствие – консерватизм отрасли ЦОДов. Системы воздушного охлаждения давно и успешно применяются и де-факто стали стандартом в дата-центрах. Целое поколение технических специалистов выросло на таких системах, имеет большой опыт их инсталляции и технического обслуживания. Привыкли к ним и проектировщики, которые закладывают в проекты новых объектов хорошо им знакомые системы воздушного охлаждения.

Важное достоинство классических систем воздушного охлаждения – легкость и удобство обслуживания ИТ-систем, их модернизации, удаления и добавления в стандартные монтажные стойки. Подобного рода требования службы эксплуатации ЦОДов вправе предъявлять и к системам погружного охлаждения, и производителям важно обеспечить выполнение этих требований. Отговорки производителей, что, дескать, системы погружного охлаждения практически не надо обслуживать, выглядят неубедительно.

Тормозит внедрение погружных систем и то, что на практике средняя мощность стойки в российских ЦОДах увеличивается крайне незначительно. Этот показатель составляет 4–5 кВт. Более того, как утверждает ряд операторов ЦОДов, даже заказчики, купившие более дорогие стойки на 7–8 кВт, фактически загружают их на те же 4–5 кВт. Таким образом, одно из основных достоинств систем погружного охлаждения – высокая плотность мощности – не востребована российской индустрией ЦОДов.

Еще одно серьезное препятствие на пути использования систем погружного охлаждения – проблема их совместимости с ИТ-оборудованием. На данный момент большая часть серверов и другого ИТ-оборудования проектируется в расчете на воздушное охлаждение. В стандартных серверах много места занимают радиаторы, вентиляторы и воздушные каналы – элементы, которые не нужны при погружном охлаждении. Производители систем погружного охлаждения вынуждены сами убирать эти элементы. Но конструкции все равно остаются громоздкими. Технология погружного охлаждения позволяет использовать более компактное оборудование, и производители начинают предлагать продукты в более компактных формфакторах, однако такие решения пока не получили широкого распространения.

Сегодня мировые производители систем погружного охлаждения ориентируются больше не на стандартные серверы, а на высокоплотные системы: суперкомпьютеры, системы HPC, кластеры GPU с ускорителями Nvidia, узлы, усиленные ядрами FPGA или параллельными процессорами, такими как Intel Zeon Phi. Хотя ведущие производители систем погружного охлаждения заявляют о совместимости своих систем с ИТ-оборудованием основных поставщиков, его использование требует уже упомянутой доработки. На рынке пока мало серверов и СХД, готовых для погружных систем.

Отдельный вопрос связан с сохранением гарантии на серверное оборудование. Часть производителей готовы сохранять гарантию модернизированных серверов, если не превышается температура эксплуатации, не возникает перебоев в электропитании и не повреждены компоненты. Поставщики процессоров также могут сохранить гарантию, если температура процессора не превышала допустимых значений – без привязки к способу охлаждения. Но этот вопрос в каждом конкретном случае надо решать отдельно. И принятие положительного решения во многом зависит от объема заказа, а пока ИТ-системы на базе погружного охлаждения внедряются в единичных экземплярах, часто в тестовом режиме.

Перспективные применения

Основными областями применения погружного охлаждения являются сегодня специализированные решения, в частности суперкомпьютеры, системы HPC и высокочастотного трейдинга, комплексы майнинга. Однако уже в самое ближайшее время такое охлаждение будет все шире применяться в «обычных» дата-центрах, в первую очередь в облачных и edge-ЦОДах.

Вот некоторые перспективные сценарии применения систем погружного охлаждения в ЦОДах.

Быстрая организация edge-ЦОДа в сложных условиях. В местах, где размещают edge-ЦОДы, часто нет подходящей инфраструктуры, а среда эксплуатации экстремальна: высокая/низкая температура, высокие влажность и уровень загрязнений. Системы погружного охлаждения не требуют подготовленной инфраструктуры и нечувствительны к сложным внешним условиям. А контейнерные (модульные) решения на базе погружного охлаждения позволяют реализовать edge-ЦОД за считанные недели. Причем в стандартный контейнер можно установить ИТ-системы мощностью сотни киловатт.

Размещение мини-/микроЦОДа в офисном помещении. Отсутствие вентиляторов делает работу ИТ-систем, погруженных в жидкость, практически бесшумной. Сама жидкость нетоксична и не представляет угрозы находящимся рядом людям. Наконец, для подключения микроЦОДа на базе системы погружного охлаждения требуется минимум инфраструктуры – только два канала для подвода и отвода жидкости. А высокая плотность мощности позволяет реализовать высокопроизводительную ИТ-систему в компактном корпусе, вписав его в интерьер современного офиса.

Наращивание ИТ-систем при отсутствии дополнительных ресурсов охлаждения, электропитания и/или свободной площади. Заменив стойки с воздушным охлаждением конструктивами с погружным охлаждением, можно кратно увеличить мощность ИТ-систем, используя имеющуюся на объекте инфраструктуру охлаждения, например чиллеры. При этом не потребуется больше электроэнергии, наоборот, ее экономия может достичь 50%. Дополнительная площадь также не потребуется.

Сокращение капзатрат на ЦОД. Построение традиционной системы охлаждения очень затратно: CFD-моделирование, выгородка коридоров, организация фальшпола, расходы на чиллеры, их обвязку, кондиционерные блоки в серверных залах и пр. – все это существенно удорожает создание дата-центров. По оценке Green Revolution Cooling, за счет отказа от компрессорных систем охлаждения (жидкость охлаждается по принципу фрикулинга) и повышения плотности размещения ИТ-оборудования системы погружного охлаждения позволяют до 50% сократить капитальные расходы на ЦОД.

Уменьшение подключенной мощности. Рекордно низкие показатели PUE системы погружного охлаждения дают возможность снизить общее потребление объекта до 50%. Это позволит владельцам/операторам дата-центров не только сократить эксплуатационные расходы, но и «вписаться» в лимит подключенной мощности, что особенно важно при создании ЦОДа в центральных районах мегаполисов, таких как Москва.

Основные тенденции на рынке ЦОДостроения – повышение плотности ИТ-оборудования при необходимости снижения расхода электроэнергии – делают системы погружного охлаждения все более востребованными. Поэтому такие системы неизбежно найдут свое применение в корпоративных и коммерческих дата-центрах. Для последних погружное охлаждение наиболее интересно при организации компактных и высокопроизводительных объектов под облачные

платформы.

Заметили неточность или опечатку в тексте? Выделите её мышкой и нажмите: Ctrl + Enter. Спасибо!