| Рубрикатор |  |

|

| Статьи |  |

ИКС № 3 2019 |  |

|

| Сергей ОРЛОВ | 11 декабря 2019 |

Гетерогенные вычисления и новые серверные платформы

Инновации в архитектуре серверов позволяют создавать вычислительные системы, которые наилучшим образом отвечают требованиям новых рабочих нагрузок.

Экспоненциальный рост данных, диверсификация приложений и ИТ-инфраструктуры заставляют искать новые подходы к вычислительным мощностям. Увеличивается разнообразие данных, и вместе с ним – необходимость применения продвинутых методов, таких как искусственный интеллект, машинное/глубокое обучение, которые помогают преобразовать эти данные в информацию. Еще один тренд – периферийные вычисления, меняющие способы использования, анализа и распространения данных. Наряду с актуальными задачами анализа больших данных и облачными вычислениями все перечисленное требует новых типов вычислительного оборудования.

Традиционные серверные архитектуры х86 на базе центрального процессора не всегда способны эффективно поддерживать новые рабочие нагрузки. Характерно, что в то время как поставки серверов с архитектурой х86 в четвертом квартале 2018 г. увеличились год к году на 18,7%, достигнув $21,1 млрд, продажи оборудования с другими архитектурами за этот же срок выросли на 21,6%, составив приблизительно $2,5 млрд (данные IDC).

Ускорители вычислений

На смену универсальным вычислениям приходят гетерогенные: обычные ЦП дополняются специализированными процессорами или ускорителями, повышающими производительность и энергоэффективность серверов при ресурсоемких рабочих нагрузках, которые становятся обычным явлением в современном дата-центре. В качестве таких ускорителей вычислений используются графические процессоры (GPU), программируемые пользователем вентильные матрицы (FPGA) и интегральные схемы специального назначения (ASIC).

Новые рабочие нагрузки определяют новые системные требования и функции, способствуют развитию и внедрению таких технологий, как NVMe, FPGA и базы данных в оперативной памяти (in-memory). По мнению аналитиков Forrester, специализированные ускорители, такие как FGPA и GPU, будут использоваться все шире. Применение графических процессоров может примерно в 25 раз ускорить выполнение отдельных видов вычислений, отмечают в 451 Research.

В иерархии процессоров – от ЦП общего назначения до ASIC – существует компромисс между гибкостью и эффективностью. Причем, как утверждают в Accenture, когда какое-либо конкретное приложение реализуется с помощью специализированных решений, производительность может увеличиться на порядки (табл. 1).

Табл. 1. Относительная иерархия аппаратных ускорителей

GPU, FPGA и ASIC могут использоваться для ускорения задач виртуализации и облачных вычислений, 3D/2D-графики, высокопроизводительных вычислений (HPC), искусственного интеллекта и машинного обучения, анализа больших данных, виртуализации сетевых функций (NFV) и др. Например, их можно с успехом применять в приложениях машинного обучения, предназначенных для распознавания голоса и изображений или анализа текста.

Комбинирование универсальных процессорных ядер со специализированными блоками вычислений по нейросетевым алгоритмам – актуальная тенденция. Специализированные микросхемы для систем искусственного интеллекта – еще один новый и быстроразвивающийся рынок. В 2018 г., по оценке Deloitte, инвестиции в разработку «нейрочипов» составили $1,5 млрд – вдвое больше, чем в 2017 г.

Свой ASIC – Edge TPU – для задач ИИ выпустила и Google. Однако сейчас в сфере обработки данных с применением ИИ наиболее известны продукты NVIDIA с ее графическими процессорами и решения Intel, такие как Nervana Neural Network Processor (NNP-I), заявленная производительность которого в части искусственного интеллекта в 10 раз выше, чем у графических карт, а также линейка FPGA Agilex для задач ИИ.

Графические процессоры

Самый распространенный тип аппаратных ускорителей, графические процессоры, нередко применяются для неграфических задач. Например, система NVIDIA DGX-1 с графическим процессором Volta разработана специально для поддержки приложений ИИ, глубокого обучения и аналитики.

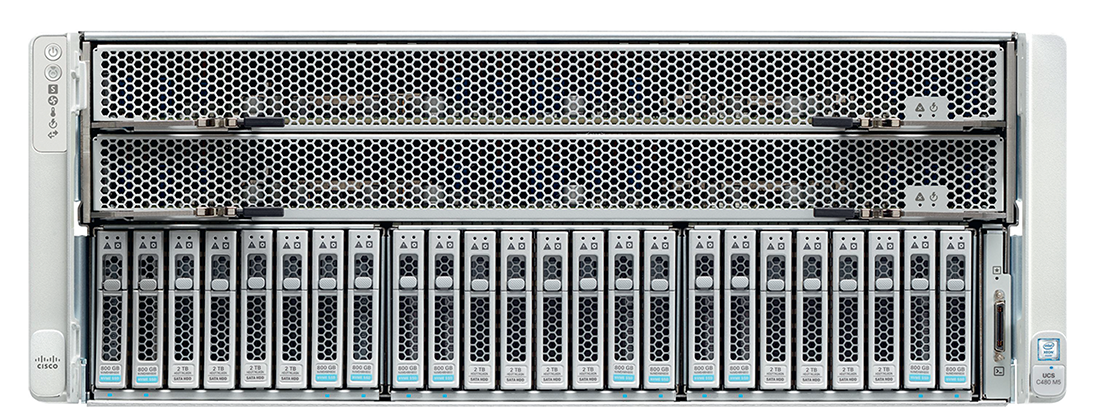

Ускорители NVIDIA GPU устанавливаются в некоторых моделях серверов Dell, HPE, Cisco, Huawei, Lenovo и др. Например, сервер Cisco C480ML (рис. 1) включает восемь GPU NVIDIA Tesla V100, до 24 накопителей общей емкостью 182 Тбайт, до шести накопителей с интерфейсом NVMe и до четырех 100-гигабитных портов. Cisco предлагает C480ML как основу, которая интегрируется с широким спектром ПО, включая Google Cloud, Kubernetes, Docker и Apache Spark для работы с Hadoop, контейнерами, рабочими нагрузками ИИ и машинного обучения. А сервер Huawei FusionServer G5500 поддерживает восемь карт-ускорителей V100 или 32 P4, использует интерконнекты GPUDirect RDMA и NVLink. Его можно применять для задач ИИ, высокопроизводительных вычислений и предоставления ресурсов GPU из облака. Модульная архитектура и эффективный теплоотвод дают возможность модернизировать систему по мере необходимости.

Рис. 1. Сервер Cisco C480ML

Большинство поставщиков облачных услуг, таких как Amazon, Microsoft и Google, предлагают своим клиентам использовать GPU в облаке. Это значительно расширяет круг компаний, которые могут позволить себе прибегнуть к расчетам на GPU или FPGA-ускорителях в своих проектах.

Ускорители FGPA

Такие ускорители задействуются в системах различных типов – от встраиваемых до платформ облачных вычислений. В отличие от универсального и графического процессоров, FPGA можно перепрограммировать в соответствии с особенностями решаемой задачи. Другие характерные особенности – архитектура с параллельным исполнением множества векторных операций, а также пониженное энергопотребление в расчете на единицу вычислительной мощности.

Intel внедряет FPGA в свои серверы на базе Xeon, Microsoft размещает FPGA на сетевых картах PCI Express в серверах, которые устанавливает в своих ЦОДах. Пример увеличения вычислительной мощности серверной системы за счет использования FPGA – анонсированный Intel FPGA-ускоритель N3000, созданный для обработки сетевого трафика с пропускной способностью до 100 Гбит/с. Он содержит 9 Гбайт памяти DDR4, 144 Мбайт памяти QDR VI и два сетевых адаптера с поддержкой восьми 10-гигабитных и четырех 2,5-гигабитных соединений. N3000 может применяться для задач виртуализации сетевых функций, а также в инфраструктуре сетей 5G.

Для Microsoft Azure и задач глубокого обучения предназначена система Microsoft Brainwave на основе FPGA. Как сообщается, алгоритмы машинного обучения Microsoft Bing на FPGA ускоряются в 40–100 раз.

В области FPGA свои решения представили такие гиганты, как Amazon, Microsoft и Facebook: AWS Inferentia, Project Brainwave и Kings Canyon. Методы разработки приложений, управления ресурсами и масштабирования систем на базе FPGA совершенствуются. Как считают в Intel, к 2020 г. треть серверов в крупных компаниях, занимающихся облачными вычислениями, будут использовать FPGA.

Однако новые веяния затрагивают и классические ЦП.

Процессоры стандартной архитектуры

Корпорация Intel недавно представила обновленную продуктовую линейку, ориентированную на обработку и хранение данных. Она включает в себя процессоры, модули памяти и сетевые адаптеры. По информации вендора, новые процессоры Intel Xeon Scalable заметно превосходят предшественников. Выигрыш составляет от 20 до 100 процентов и выше и наиболее заметен при решении таких задач, как обработка больших данных и анализ изображений.

Клиенты оценивают рост производительности ЦП в среднем на уровне 40%, однако в области анализа данных выигрыш составляет около 50%, а в задачах, связанных с высокопроизводительными вычислениями, он является уже двукратным. По наблюдениям, при использовании аналитических платформ, основанных на парадигме больших данных, показатели производительности могут быть втрое выше.

Процессорами инновации Intel не ограничиваются. Заявлена также возможность применения накопителей Optane в качестве своего рода дополнения к ОЗУ, причем энергонезависимого. Как показывает практика, ресурсы ЦП обычно используются на 30%, а оперативная память задействуется полностью. В этих условиях применение модулей Optane -- способ повышения производительности. Новые Ethernet-адаптеры Intel 800 100 Гбит/с дают выигрыш в производительности до 45%.

Недавно компания официально заявила, что в 2020 г. выпустит свою первую дискретную видеокарту. Кодовые наименования будущих дискретных графических процессоров Intel -- Arctic Sound (рис. 2) и Jupiter Sound. Arctic Sound будет представлять графику 12-го поколения и использовать для подключения к процессору интерконнект EMIB (Embedded Multi-Die Interconnect Bridge).

Рис. 2. Видеокарта Intel Arctic Sound

Впервые мы увидим на рынке GPU сразу трех игроков – Intel, NVIDIA и AMD. Хотя NVIDIA и AMD имеют многолетний опыт в области GPU, производственные мощности Intel могут дать ей преимущество.

Процессоры AMD EPYC

В отрасли растет интерес к производительным периферийным вычислениям, системам, ориентированным на машинное обучение, ИИ и машинное зрение. На подобные нагрузки рассчитаны процессоры AMD EPYC с большим числом одновременно задействованных линий PCI Express.

Dell EMC уже пополнила свое семейство серверов PowerEdge 14-го поколения системами на базе AMD EPYC. Как сообщается, предназначены они для программно конфигурируемых сред, периферийных и высокопроизводительных вычислений. Системы PowerEdge R6415, R7415 (рис. 3) и R7425 с процессорами AMD EPYC обладают высокой пропускной способностью оперативной памяти и плотностью вычислительных ядер, демонстрируют хорошие результаты в широком диапазоне рабочих нагрузок HPC. Односокетная система Dell EMC PowerEdge R7415 в корпусе 2U сертифицирована как узел VMware vSAN Ready Node. Благодаря оперативной памяти емкостью до 2 Тбайт и наличию до 24 накопителей NVMe сервер можно применять в качестве недорогого программно определяемого хранилища данных (SDS).

Рис. 3. Односокетная система Dell EMC PowerEdge R7415

Новые серверы Dell EMC используют возможности процессоров AMD EPYC с поддержкой до 32 ядер (64 потоков), восьми каналов памяти и 128 линий PCIe. Они созданы специально для рабочих нагрузок нового типа, таких как хранилища SDS и гетерогенные вычисления. Эти серверы обеспечивают увеличенную полосу пропускания трафика «восток/запад» (т.е. между серверами в ЦОДе) для поддержки облачных вычислений и виртуализации.

Компания Supermicro также представила серверную платформу A+ на базе AMD EPYC Embedded 3000. Она предназначена для сетевых приложений, включая vCPE/uCPE, SD-WAN, обеспечения сетевой безопасности, частных облаков и периферийных вычислений.

В октябре 2018 г. AMD анонсировала инстансы Oracle Cloud Infrastructure на платформе AMD EPYC. Oracle стала крупнейшим облачным провайдером, предоставляющим доступ к платформам на базе процессоров AMD EPYC без операционной системы (bare metal). Как заявлено, инстанс на базе AMD EPYC обойдется клиентам на 66% дешевле конкурентных предложений по стоимости ядра в час. Ускоренные Oracle облачные конфигурации bare metal также включают в себя графические процессоры NVIDIA.

Представленные в конце 2018 г. компанией AMD серверные 64-ядерные процессоры EPYC Rome на базе новой архитектуры Zen 2 стали первыми процессорами архитектуры x86 с нормами технологического процесса 7 нм. Двухпроцессорные серверы получат 128 вычислительных ядер и будут поддерживать 256 вычислительных потоков. Процессоры AMD EPYC Milan с архитектурой Zen 3 будут выпускаться в следующем году по второму поколению 7 нм-техпроцесса.

Между тем новые задачи заставляют производителей серверов обращаться и к альтернативным х86 процессорным архитектурам.

Процессоры ARM

Ожидается, что в этом году альтернативы архитектуре х86 для ресурсоемких приложений, например процессоры на базе архитектуры Advanced RISC Machine (ARM), получат дальнейшее развитие: амбициозные планы ARM предполагают создание к 2021 г. экосистемы стоимостью $100 млрд (рис. 4). Это означает, что системным администраторам придется расширить свой кругозор для поддержки систем с различными типами микропроцессоров.

Рис. 4. Рост объема поставок процессоров на базе архитектуры ARM

Серверные процессоры на базе ARM разрабатывают такие компании, как AMD, AppliedMicro, Broadcom, Cavium и QualComm. Системы на базе ARM могут обладать привлекательными показателями совокупной стоимости владения и энергоэффективности. Они хорошо подходят для облачных рабочих нагрузок (IaaS, PaaS), машинного обучения и работы с большими данными, однако могут потребовать переноса, перекомпиляции, либо полного переписывания существующего программного обеспечения.

Согласно представленной компанией ARM стратегии Neoverse, планируются три крупных этапа, в рамках которых будут выходить доступные для широкого лицензирования 64-разрядные ядра ARM Ares (7 нм), Zeus (7 и 5 нм) и Poseidon (5 нм). Предполагается, что каждый год производительность этих решений будет возрастать на 30%.

Neoverse N1 предусматривает выпуск 7-нм ядер Ares. Процессоры могут содержать от четырех до 128 ядер, объединенных когерентной ячеистой сетью (Coherent Mesh Network, CMN). Платформа N1 может служить основой как периферийных систем с 8-ядерным процессором с потреблением менее 20 Вт, так и мощных серверов для ЦОДов на 128-ядерных процессорах с термопакетом до 200 Вт. По данным ARM, у ядер N1 производительность на облачных нагрузках в 2,5 раза больше, чем у 16-нм ядер предыдущего поколения (Cortex-A72, A75 и A53), скорость целочисленных операций выше на 60%, а энергоэффективность – на 30%.

Сеть CMN распределяет кэш-память между ядрами и способствует оптимизации вычислений. Для ЦП с числом ядер от 64 до 96 компания ARM рекомендует использовать восьмиканальный контроллер памяти DDR4, а для 96–128-ядерных версий – DDR5.

Другая платформа, Neoverse E1, – решение для сетевых шлюзов, коммутаторов и сетевых узлов. По сравнению с предыдущими платформами ARM она обещает рост пропускной способности в 2,7 раза, эффективности при передаче данных – в 2,4 раза, а также более чем двукратное увеличение вычислительной мощности.

RISC-V: процессоры с открытыми спецификациями

Еще одна альтернативная архитектура получила название RISC-V. Она позволяет создавать полностью открытые «системы на чипе» (SoC) и процессоры. Linux Foundation анонсировала проект CHIPS (Common Hardware for Interfaces, Processors and Systems) Alliance, участники которого займутся развитием процессоров с открытыми спецификациями. Первыми членами альянса стали Esperanto, Google, SiFive и Western Digital. Участники организации будут поддерживать открытую спецификацию архитектуры набора команд RISC-V.

В рамках CHIPS Alliance производители намерены продвигать проекты готовых реализаций открытых ЦП и однокристальных систем с архитектурой RISC-V. Участники альянса планируют, в частности, разработать открытые блоки для процессорных ядер и SoC, которые найдут применение в облачных платформах и дата-центрах.

В рамках CHIPS Alliance уже реализуется ряд проектов. В их числе: SweRV Core – 32-разрядный RISC-V процессор Western Digital, RocketChip SoC, создаваемый в SiFive, когерентный интерфейс TileLink для интеграции компонентов SoC и фреймворк Diplomacy.

RISC-V – единственная процессорная архитектура, которая имеет набор команд с открытыми исходными кодами. К ее преимуществам относят возможность разработки продуктов, ориентированных на специфическую вычислительную нагрузку, экономию времени и денег, безопасность и удобство.

Другие альтернативы

Стоит отметить еще пару альтернативных архитектур – достойных конкурентов х86. Построенные на базе микропроцессора SPARC M8 системы Oracle и сервисы IaaS предоставляют заказчикам корпоративную платформу, включающую «ПО на кристалле» (Software in Silicon). Они предназначены для развертывания бизнес-приложений и горизонтально масштабируемых прикладных сред с экстремально высокой производительностью, как на своей площадке, так и в облаке Oracle Cloud. По оценке Oracle, системы на процессорах SPARC обеспечивают производительность, эффективность и возможности обеспечения безопасности, в 2–7 раз превосходящие показатели систем на базе процессоров Intel.

Компания Qualcomm представила аппаратный ускоритель для ЦОДа, призванный улучшить вычисления в области ИИ, – Cloud AI 100. Как утверждают разработчики, их решение на порядок повышает эффективность расчетов по сравнению с FPGA. Оно создано на основе наработок в области платформ для мобильных устройств Snapdragon. Однако производительность Cloud A1 100 на задачах искусственного интеллекта в 50 раз больше производительности Snapdragon 8250. Cloud A1 100 будет использоваться в облачных и периферийных вычислениях. Процессор будет выполняться по технологии 7 нм в различных формфакторах для нужд разных заказчиков.

Компания IBM в 2018 г. выпустила четырехсокетный сервер Power System E950 в шасси 4U для облачных рабочих нагрузок и хранения данных. Он ориентирован на средние и крупные организации и имеет встроенные функции виртуализации и обеспечения безопасности на всех уровнях, от процессора до операционной системы. Модель E950 оснащается процессорами Power9 (до 48 ядер), имеет 10 слотов шины PCI и до 16 Тбайт памяти.

Пора обновления

Одни технологические новации закономерно сменяют другие. Технологии, которые когда-то были передовыми, обеспечивали самую высокую производительность ИТ-систем, со временем устаревают и начинают тормозить развитие компании. Чтобы двигаться вперед, приходится отказываться от старого.

Устаревшая ИТ-инфраструктура может негативно влиять на производительность, требовать дополнительной поддержки и непредвиденных расходов на обслуживание. Все это не лучшим образом сказывается на способности компании решать стоящие перед бизнесом задачи.

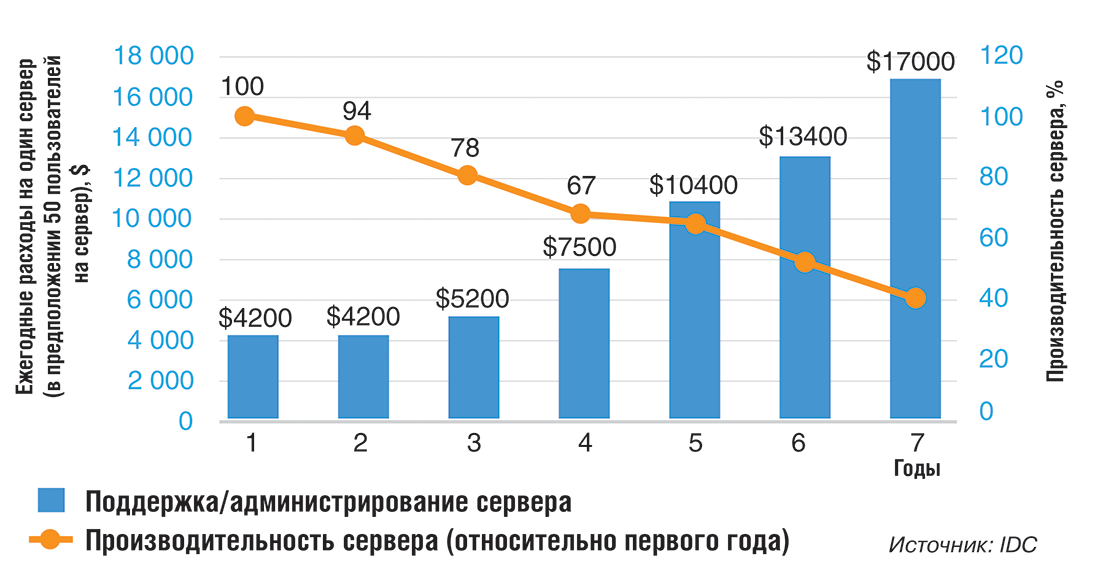

Рис. 5. Изменение производительности и расходов на администрирование систем относительно начального уровня по мере устаревания серверов

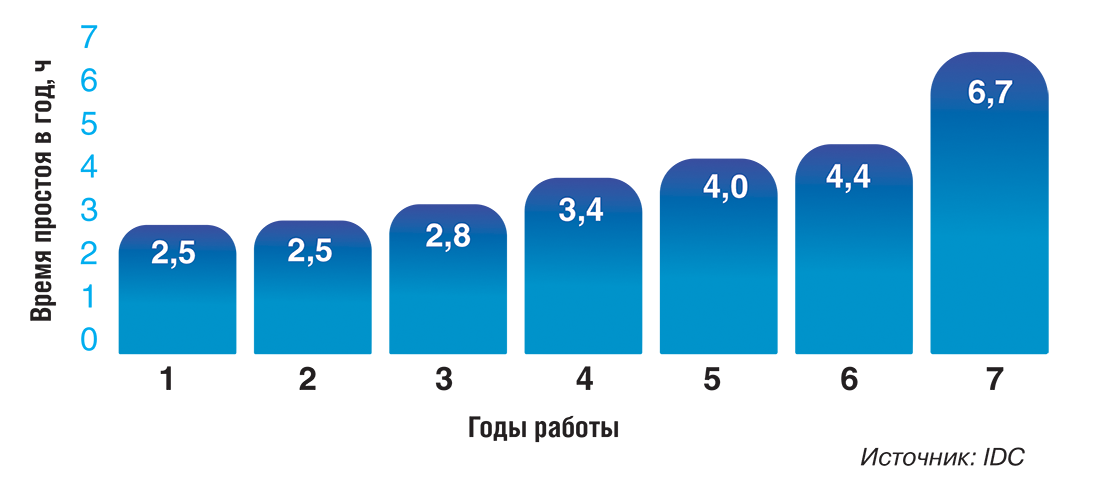

Рис. 6. Рост времени незапланированного простоя на протяжении срока эксплуатации серверов

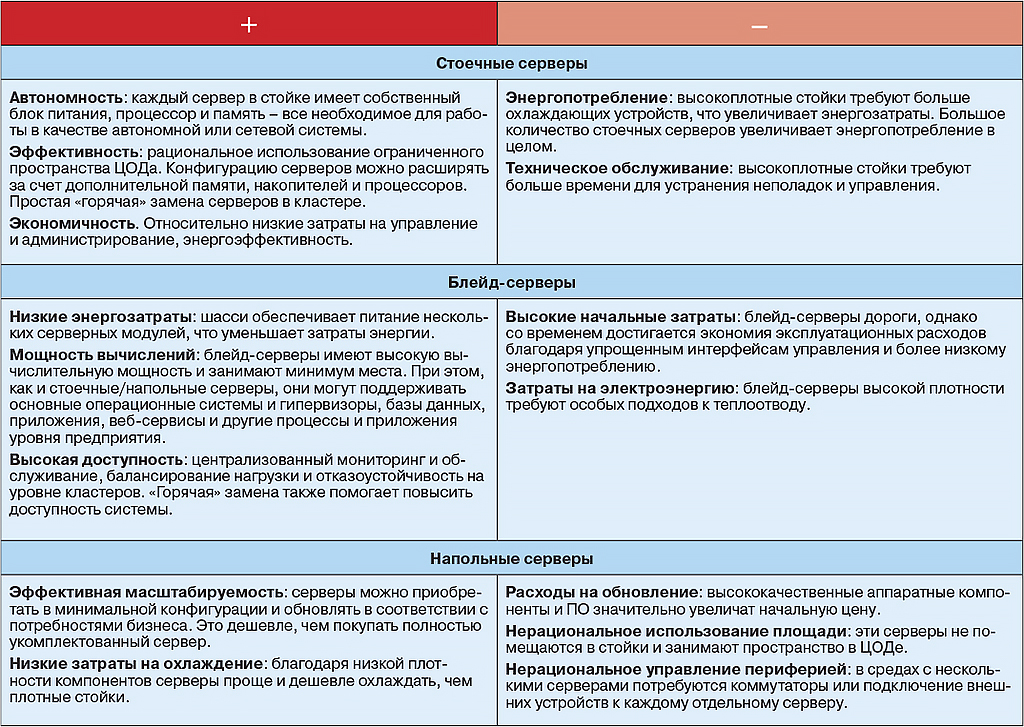

По мнению аналитиков IDC, пренебрежение своевременным обновлением серверной инфраструктуры может привести к почти 40%-ной потере производительности, повысить затраты на управление приложениями и администрирование серверов (рис. 5), увеличить время простоя (рис. 6). Это говорит о том, что серверные платформы пора модернизировать. А это может означать не только новую «начинку» серверов, но и выбор оптимального формфактора системы (табл. 2).

Табл. 2. Плюсы и минусы основных формфакторов серверов

Увеличение количества ЦП для обработки больших объемов данных может оказаться экономически нецелесообразным. Технологии ускоренных вычислений реализуют возможности высокопроизводительных вычислительных серверов в более экономичных серверах с одним или двумя сокетами. Такие решения доступны большинству организаций.

* * *

Цифровая трансформация в бизнесе, как считают в IDC, означает внедрение правильных приложений в подходящей для них инфраструктуре. По мнению специалистов IBM, оптимален поэтапный подход. В итоге он позволит получить доступ к таким инструментам, как предиктивная и высокопроизводительная аналитика. Машинное обучение и обработка естественного языка становятся распространенными технологиями и применяются не только в ИТ. Они дают возможность, в частности, обнаруживать скрытые связи в данных, делать прогнозы. Чем больше данных, тем точнее результат.

В течение следующих пяти лет компаниям, инвестируя в свою ИТ-инфраструктуру, следует тщательно сравнивать показатели серверов с различными архитектурами, подбирая для своих задач платформы с наиболее подходящими процессорами и ускорителями, не ограничиваясь стандартными, универсальными решениями.

Сергей Орлов, независимый

эксперт

Заметили неточность или опечатку в тексте? Выделите её мышкой и нажмите: Ctrl + Enter. Спасибо!