| Рубрикатор |  |

|

| Все новости |  |

Новости отрасли |  |

|

| Николай НОСОВ | 23 апреля 2019 |

Новое поколение серверных процессоров Intel

Компания Intel представила второе поколение процессоров семейства Xeon Scalable, получившее название Cascade Lake. Решения компании обеспечивают рост производительности обработки данных и ускоряют исполнение моделей в топологии нейронной сети.

Представляя новые процессоры, региональный директор Intel в России Наталья Галян отметила, что половина мировых данных была создана за последние два года и только 2% из них были проанализированы. Стремительный рост объема данных требует новых решений в области хранения, передачи и обработки. Компания Intel все шире предлагает разработки для дата-центров, инфраструктур хранения и передачи данных, искусственного интеллекта и интернета вещей, всего рынка полупроводниковых технологий, который, по оценкам компании, достигнет $320 млрд в 2023 году.

Новые процессоры, новая память

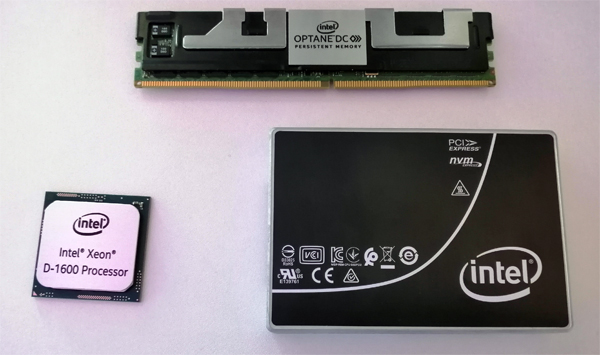

Intel изменила традиционную иерархию систем хранения компьютера: кэш процессора – оперативная память – дисковая память. Помимо быстрой, но дорогой оперативной памяти (DRAM) компания предлагает более дешевую постоянную память Intel Optane DC, которая начиная со второго поколения платформы Xeon Scalable обеспечивает увеличение объема оперативной памяти до 4,5 Тбайт на сокет CPU. Совместимые с первым поколением Skylake процессоры Cascade Lake поддерживают модули памяти Optane DC, размещаемые в слотах DDR4.

Директор по развитию бизнеса SDS&HC в России и СНГ компании VMware Николай Куликов отметил, что измеренная производительность приложений в виртуализированных средах VMware по тесту VMmark 3.1 на серверах HPE ProLiant Gen10 с процессорами Cascade Lake и постоянной памятью Optane DC эквивалентна производительности на таких же серверах с обычной DRAM-памятью.

Компания МТС представила результаты тестов, согласно которым использование постоянной памяти Optane DC в комбинации с процессорами Xeon Scalable 2-го поколения позволяет добиться четырехкратного увеличения производительности при обработке крупных объемов данных.

Промежуточное положение по производительности между классическими жесткими дисками, предназначенными для хранения «холодных» данных, и оперативной памятью, занимают новые накопители Optane SSD DC D4800X (Dual Port) и SSD D5-P4326 (Intel QLC 3D NAND) для центров обработки данных, совместимые с формфактором EDSFF.

Сдвиг фокуса на предоставления решений для дата-центров вполне понятен, ведь большая часть увеличивающегося объема данных будет обрабатываться именно в них. Для быстрой обработки данных предназначены и новые мощные процессоры серии Intel Xeon Platinum 9200, которые могут иметь до 56 ядер и поддерживать до 12 каналов памяти. По сравнению с первым поколением процессоров производительность топовых моделей на реальных нагрузках возросла в среднем в 1,33 раза.

Для передачи масштабных объемов данных предназначен новый сетевой адаптер Intel Ethernet 800 Series с технологией Application Device Queues, способный обеспечить работу на скорости до 100 Гбит/с.

Производительные CPU и быстрые диски повышают возможности пользователей в разных сферах. «Рендеринг в CG – это одна из самых требовательных к вычислительным ресурсам серверной фермы операция. Создание CG-эффектов требует дней, недель иногда даже месяцев расчетов. Благодаря процессорам Xeon Scalable и особенно твердотельным NVMe-дискам Intel время таких расчетов сократилось в сотни раз», – отметил технический директор российской студии визуальных эффектов Main Road Post Михаил Лёсин.

Новые возможности для ИИ

Быстро растет рынок обработки данных в области искусственного интеллекта. По прогнозам Intel рынок решений для ИИ вырастет более чем в три раза по сравнению с 2017 годом и составит в 2022 году $8–10 млрд.

Компания откликнулась на запрос рынка и добавила набор инструкций Vector Neural Network Instructions (VNNI) для ускорения работы нейронных сетей. Общее название всех аппаратных и программных оптимизаций для задач ИИ новых процессоров получило название Deep Learning Boost (DL Boost).

Новое поколение процессоров быстрее выполняет операции с векторами, что важно при исполнении моделей машинного обучения в топологии нейронных сетей. Обработка чисел с плавающей запятой может быть избыточной при исполнении (inference) обученных нейронных сетей, а именно в таком режиме чаще всего используют CPU. Работа с целыми числами (INT8) в VNNI уменьшает количество необходимых для выполнения операций инструкций. Например, для часто используемой операции совмещенного умножения-сложения (multiply-accumulate, MAC), когда умножаются два числа и складываются с аккумулятором – регистром процессора для хранения результатов выполнения команд, теперь используется одна инструкция. Меньшая сложность приводит к снижению нагрузки на кэш, увеличению пропускной способности памяти и скорости расчетов в целом.

По словам Александра Кондакова, менеджера специализирующейся на распознавании видеоизображений компании AxxonSoft, тестирование показало, что исполнение обученной нейронной сети на сервере с DL Boost (Xeon 6240C) происходит в 1,6 раза быстрее, чем на имеющем такое же количество ядер процессоре первого поколения Skylake (Xeon 6140). Тестирование проводилось с использованием набора инструментов Intel OpenVINO, уже поддерживающего работу с новыми процессорами.

Компании активно разрабатывают и выпускают на рынок микропроцессоры для обучения нейросетей и исполнения обученных моделей. Тензорные процессоры из облака предлагает Google, решения для центров обработки данных и конечных пользователей – NVIDIA и Huawei. Для решения задач ИИ используют CPU, специализированные микропроцессоры (ASIC), графические процессоры (GPU) и FPGA.

Все решения имеют свои преимущества и ограничения в зависимости от конкретных проектов. Достоинством CPU Intel Cascade Lake является универсальность – возможность использования для широкого круга задач, что особенно ценно для гибкости предоставления сервисов дата-центров по облачной модели. Одна и та же вычислительная инфраструктура может использоваться для классических вычислительных задач и для выполнения решений ИИ.

Причем не обучение, а исполнение моделей в топологии нейронной сети требует больших вычислительных мощностей, например, при одновременном обращении тысяч пользователей к веб-сервису, используещему обученные нейронные сети. И именно на повышение производительности исполнения обученных моделей сделан упор в Intel Xeon Scalable Cascade Lake.

Читайте также:

«Лаборатория Касперского» запускает платформу для создания решений на основе нейроморфных технологий

Разработчик отечественных микропроцессоров получил 200 миллионов

Тайваньская компания TSMC полностью прекратила производство и поставки своей продукции в Россию

МТС улучшит обслуживание в чатах поддержки с помощью нейронных сетей

Московский Политех подготовит специалистов в области микропроцессорной техники и цифровизации

Оставить свой комментарий:

Комментарии по материалу

Данный материал еще не комментировался.