| Рубрикатор |  |

|

| Статьи |  |

|

| Александр БАРСКОВ | 31 января 2024 |

ЦОДы для искусственного интеллекта

Многие страны и компании надеются, что искусственный интеллект станет основой их конкурентоспособности. Но для того чтобы ИИ заработал «на полную катушку», необходимо подготовить ЦОДы. Как они должны измениться? И надо ли им вообще меняться?

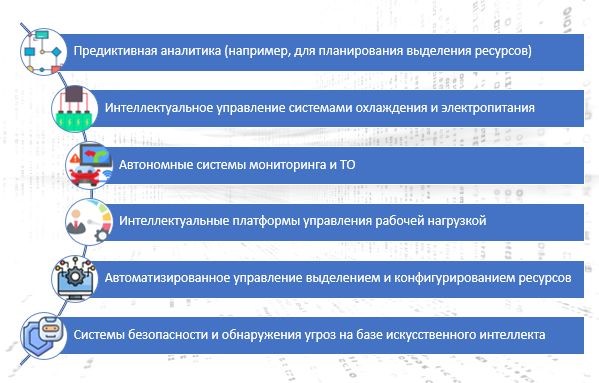

В последнее время много рассуждают о том, как искусственный интеллект изменит процессы эксплуатации ЦОДов. Безусловно, системы с использованием ИИ способны существенно повысить уровень автоматизации и эффективность многих важных процессов, включая выделение и конфигурирование различных ресурсов (электропитание, охлаждение, технологическое пространство), управление инженерными системами, рабочей (ИТ-) нагрузкой, обеспечение физической и информационной безопасности (рис. 1).

Рис. 1. Примеры использования ИИ в ЦОДах

Однако прежде чем обсуждать то, как ИИ в перспективе изменит процессы эксплуатации ЦОДов, важно разобраться, как сами ЦОДы должны измениться, чтобы обеспечить эффективную работу систем ИИ. Ведь дата-центр – это не только потребитель результатов деятельности ИИ, но и платформа для функционирования соответствующих приложений. А они представляют собой во многом нетипичную рабочую нагрузку.

Системы с ИИ требуют огромных объемов вычислительных ресурсов, особенно на стадии обучения моделей. Для повышения производительности таких систем предпочтительно использовать невиртуализированные среды, а именно серверы с графическими процессорами (GPU).

Bare metal рулит

Последние годы виртуализация ИТ-инфраструктуры была в числе главных трендов. Причина понятна: виртуализация позволяет более эффективно использовать физические ресурсы, она делает инфраструктуру более гибкой и адаптивной. Неудивительно, что именно виртуальные машины стали основным инфраструктурным ресурсом для размещения рабочих ИТ-нагрузок. Но с учетом «любви» искусственного интеллекта к «голому железу» операторам ЦОДов для поддержки соответствующих приложений придется расширять предложение сервисов bare metal.

Запуск рабочих нагрузок на «голом железе» существенно облегчает жизнь сервис-провайдеру: не нужны никакие гипервизоры, оркестраторы и другие элементы платформ виртуализации. Но при этом может понадобиться обновить серверный парк, а, возможно, и стойки, в которых размещается ИТ-оборудование. Провайдеры нередко практиковали приобретение мощных серверов, которые затем разделялись на множество виртуальных машин. Но в ситуации, когда будет требоваться много отдельных физических серверов, ориентация на мощные компьютеры может оказаться неоправданной. Логичнее установить большее количество менее мощных серверов с GPU-ускорителями. Короче говоря, предстоит масштабная замена серверного парка.

Низкая задержка – высокая плотность

Системам с ИИ нужны каналы связи со сверхнизкой задержкой. Следует заметить, что ЦОДы всегда стремились иметь высокопроизводительные сети с минимальной задержкой. Для снижения задержки в свое время классическая трехуровневая сетевая архитектура «доступ – агрегация – ядро» была заменена на архитектуру leaf – spine, уменьшающую число сетевых пролетов (а значит, и задержку) между узлами. Ну а каналы передачи данных в современных дата-центрах уже вышли на уровень 100G и выше. Чтобы в полной мере воспользоваться преимуществами искусственного интеллекта, необходимо еще больше снизить задержку. Здесь уже на первое место выходит вопрос расстояния, а потому системы для ИИ размещают максимально компактно, что увеличивает плотность энергопотребления.

Чтобы разобраться, насколько плотной должна быть среда для ИИ, давайте углубимся в «анатомию» ИТ-систем для искусственного интеллекта. Флагманский процессор для таких систем – Nvidia H100 (рис. 2), выпущенный компанией в 2022 г. под кодовым названием Hopper (в честь ученого-компьютерщика ВМС США Грейс Хоппер, которая стала пионером компьютерного программирования). Этот чип изготавливается тайваньской TSMC по 4-нм техпроцессу, что обеспечивает примерно на 50% большее количество транзисторов (около 80 млрд) по сравнению с предыдущим семейством чипов Ampere.

Источник: Nvidia

Рис. 2. Nvidia H100 GPU на модуле SXM5

К концу 2023 г. Nvidia поставила, по разным оценкам, 500–600 тыс. чипов Hopper. В текущем году будет выпущено уже 1,5–2 млн этих чипов, и серверами с ними будет полностью заполнено примерно 50 тыс. ИТ-стоек (здесь и далее в расчетах предполагается использование наиболее популярных на сегодня стоек высотой 42U). Однако, скорее всего, стоек будет гораздо больше из-за ограничений, связанных с доступными плотностью электрической мощности и производительностью систем охлаждения.

Если бы все эти системы искусственного интеллекта были постоянно полностью загружены, это означало бы добавление около 2000 МВт новой ИТ-нагрузки. Важно заметить, что эта оценка произведена только для чипов Hopper, тогда как у той же Nvidia немало других моделей GPU. Есть и другие поставщики графических процессоров.

Источник: Nvidia

Рис. 3. Сервер Nvidia DGX

Но вернемся к вопросу плотности. Одна из наиболее популярных систем для ИИ-приложений – серверы Nvidia DGX. Сегодня доступно уже четвертое поколение таких машин. Сервер DGX H100 (рис. 3) имеет восемь графических процессоров GPU H100, два ЦПУ Intel Xeon Sapphire Rapids, 8 × 400 Гбит/с InfiniBand/Ethernet-коммутатор ConnectX-7, а также высокоскоростное хранилище NVMe SSD на 30 Тбайт. Этот сервер имеет высоту 8U и номинальную мощность 10,2 кВт, т.е. 1,275 кВт на 1U. Типовое потребление (и, соответственно, тепловыделение), вероятно, ближе к 7–8 кВт. Nvidia предлагает инструменты управления питанием, чтобы клиенты могли размещать до четырех систем в стойке, не нарушая ограничений по подаче электроэнергии.

Даже при максимально плотной набивке стойки серверами DGX H100 ее максимальная мощность составит 35 кВт (для расчета взято среднее энергопотребление одного сервера 7 кВт). Тогда как некоторые ИТ-визионеры пугают нас тем, что для ИИ нужны стойки на 50 кВт и выше. Практики же говорят, что реальная плотность на самом деле еще ниже. Так, по словам представителей компании Selectel, их платформа AI&ML (искусственного интеллекта и машинного обучения) функционирует на стойках мощностью 12–15 кВт.

Если принять за верхний уровень 35 кВт на стойку, то это тепловыделение при известных ухищрениях, таких как качественная изоляция воздушных потоков, установка внутрирядных кондиционеров и пр., вполне можно снять с помощью апробированных годами систем воздушного охлаждения. В России есть ЦОДы, в которых, по заявлениям их руководителей, воздухом может сниматься до 50–55 кВт на стойку. Но эти решения пока нельзя отнести к типовым.

Использование перспективных систем жидкостного охлаждения для серверов ИИ (рис. 4) интересно тем, что позволит снизить энергопотребление за счет отказа от вентиляторов (они могут потреблять до 20% всей мощности) и максимально увеличить производительность GPU и CPU. Непосредственное охлаждение жидкостью дает возможность снимать до 100 кВт (и даже более) тепловой нагрузки с одной стойки или сопоставимой с ней по размерам ванны (куда погружаются платы серверов).

Источник: https://bizon-tech.com/

Рис. 4. Сервер c GPU Nvidia и жидкостным охлаждением

Однако системы жидкостного охлаждения пока не получили широкого распространения. Основная причина – отсутствие стандартов для этой технологии. Разные производители используют разные охлаждающие жидкости, нестандартизованные блоки распределения жидкости, а потому ЦОДы могут оказаться привязаны к одному производителю подобной системы охлаждения. В свою очередь, вендоры ИТ-оборудования не обеспечивают такой же полной поддержки систем жидкостного охлаждения, как воздушного. Наконец, для работы с системами жидкостного охлаждения нужна переподготовка персонала, а это требует времени и денег. Но даже при обученном персонале внедрение таких систем повышает эксплуатационные риски из-за относительно низкой зрелости процедур и может привести к более высокому, чем обычно, числу сбоев и неполадок.

Всегда ли нужны GPU

Но всегда ли системам ИИ нужны большие ресурсы GPU? На самом деле они требуются на этапе обучения модели. Затем потребность в ресурсах заметно снижается – до тех пор, пока не придет время переобучать модель. Поэтому оснащать корпоративный ЦОД дорогостоящими серверами с GPU, чтобы использовать их на полную мощность только эпизодически, вряд ли разумно.

Рост популярности приложений с ИИ станет очередным мощным катализаторов перехода на сервисную модель, в рамках которой клиенты смогут получать доступ к необходимым ресурсам, размещенным в коммерческом ЦОДе, и, соответственно, оплачивать только реально потребленные ресурсы. Неудивительно, что аналитики прогнозируют бум спроса на услуги типа GPUaaS. Так, по предварительным данным Future Market Insights, глобальный рынок услуг GPUaaS в 2023 г. составил около $3,9 млрд. В ближайшие 10 лет его объем будет ежегодно расти в среднем на 40,8% и к 2033 г. достигнет $119,6 млрд.

Революция, связанная с искусственным интеллектов, еще не завершена. Поэтому нельзя точно предсказать, как искусственный интеллект изменит инфраструктуру и работу ЦОДов. Ведь в более отдаленной перспективе в процесс могут вмешаться квантовые компьютеры со своими специфическими требованиями к системам электропитания и охлаждения. Но можно с уверенностью утверждать, что такие изменения, как увеличение числа серверов с поддержкой GPU и более гибкие модели их использования окажутся критичными в мире, ориентированном на искусственный интеллект. Операторы ЦОДов, которые хотят получить свой кусок пирога на рынке ИИ, должны оперативно обновить инфраструктуру, чтобы она соответствовала специфическим требованиям соответствующих приложений.

По прогнозу Nvidia, уже в ближайшее время на модернизацию центров обработки данных для ИИ будет потрачено около $1 трлн. Поэтому, чтобы хорошо заработать на ИИ, провайдерам надо сначала потратиться на подготовку своих дата-центров.

Заметили неточность или опечатку в тексте? Выделите её мышкой и нажмите: Ctrl + Enter. Спасибо!