| Рубрикатор |  |

|

| Статьи |  |

ИКС № 2 2023 |  |

|

| 23 июня 2023 |

Пять прогнозов для ЦОДов на 2023 год. Прогноз 3

Объекты, построенные сегодня, должны оставаться экономически конкурентоспособными и технически работоспособными в течение 10–15 лет. Но проектировщикам ЦОДов неизвестны будущие спецификации ИТ-стоек, и технические требования к ЦОДам второй половины 20-х годов и далее пока не сформировались. Поэтому инженерам и лицам, принимающим решения, придется исходить из гипотез.

ЦОДам предстоит подстроиться под новые чипы

Стандартизация ИТ-оборудования стала для ЦОДов благом: в течение почти двух десятилетий типовые серверы предъявляли более или менее неизменные требования к питанию и охлаждению. Эта техническая стабильность упростила планирование и проектирование объектов и помогла привлечь инвестиции в индустрию ЦОДов. Многие организации смогли провести несколько обновлений ИТ-оборудования без серьезной модернизации инженерной инфраструктуры, благодаря чему продолжительность жизни дата-центров увеличилась.

Стабильность требований помогла и проектировщикам ЦОДов. Они могли с уверенностью закладывать проектную мощность в среднем 4–6 кВт на стойку, а при определении критериев управления температурой следовать рекомендациям ASHRAE. Такая согласованность в вопросах плотности мощности и охлаждения, конечно, зависела от стабильного, предсказуемого энергопотребления процессоров и других серверных компонентов.

Однако наблюдаемый сегодня быстрый рост плотности ИТ-мощности означает, что проектные предположения относительно будущей плотности мощности и рабочей среды начинают меняться. Это увеличивает технические и бизнес-риски. Будете слишком консервативны (т.е. сохраните подход с низкой плотностью), и ЦОД может быстро стать неподходящим для установки нового оборудования. Будете слишком прогрессивны (т.е. предположите высокую плотность мощности и повторное использование тепла) – рискуете значительно перерасходовать средства из-за недоиспользуемых мощностей.

Температура серверов повышается

Мощность серверов и соответственно мощность заполненной серверами стойки становятся все выше. Стойки с экстремальной плотностью мощности все чаще используются, например, в системах высокопроизводительной аналитики и искусственного интеллекта.

Пока тепловая мощность сервера оставалась относительно скромной, удалось установить отраслевые стандарты в области воздушного охлаждения. Первоначальные рекомендации ASHRAE по диапазонам температуры и влажности (предложены в 2004 г., почти 20 лет назад) отвечали потребностям большинства операторов. Впоследствии ASHRAE поощряла постепенное повышение допустимой температуры, помогая отрасли добиться большей энергоэффективности объектов.

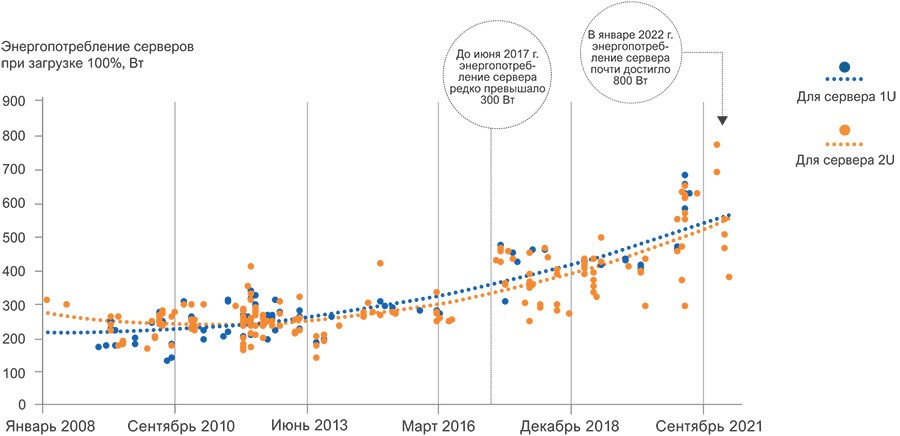

Исследования Uptime Institute показывают, что за последнее десятилетие удельная мощность стойки умеренно, но постоянно растет. (Вопреки некоторым ожиданиям, типичное энергопотребление стойки остается ниже 10 кВт.) Эксперты Uptime ожидают, что этот рост в ближайшее время ускорится. Увеличение удельной мощности стоек связано не только с более плотной упаковкой серверов, но и с ростом энергопотребления каждого сервера, что обусловлено появлением на массовом рынке более мощных серверных процессоров, которые более производительны и энергоэффективны – при правильном использовании (рис. 3).

Источник: SPEC.ORG, подготовлено Uptime Institute

Рис. 3. Изменение энергопотребления серверов

Эта тенденция скоро начнет влиять на нынешние подходы к проектированию ЦОДов. Более «горячие» процессоры уже появились. Новая серия серверных процессоров Intel имеет расчетную тепловую мощность (TDP) 350 Вт и возможность дополнительной настройки до более чем 400 Вт (по сравнению с 120–150 Вт всего 10 лет назад). Через несколько лет предполагается выпустить процессоры с TDP 500–600 Вт. В результате энергопотребление базовых серверов приблизится к 1 кВт или более, что повысит требования как к электропитанию, так и к управлению температурой.

Серверы для высокопроизводительных вычислений (HPC) могут служить ранним предупреждением о проблемах с охлаждением, с которыми столкнутся пользователи обычных серверов по мере увеличения их энергопотребления. ASHRAE в обновлении 2021 г. определила новый тепловой стандарт (класс H1) для серверов высокой плотности, требующий снижения температуры подаваемого воздуха до 22°C, что означает ухудшение энергоэффективности и дополнительные расходы на охлаждение. Во многом это обусловлено большим количеством тесно интегрированных компонентов высокой мощности. Ускорители HPC, такие как графические процессоры, могут потреблять сотни ватт каждый при максимальной мощности – в дополнение к серверным процессорам, модулям памяти и другой электронике.

В ближайшие годы появится больше базовых серверов с аналогичными требованиями к охлаждению – даже без ускорителей. Помимо повышения тепловой мощности процессора следует учитывать и ужесточение требований к допустимой температуре корпуса процессора – например, 55°C, по сравнению с 80–82°C сегодня. А удаление больших объемов низкотемпературного тепла – непростая термодинамическая задача.

Как соблюсти баланс

Многим существующим ЦОДам увеличить плотность энергопотребления будет трудно. Повышение мощности и/или холодопроизводительности может потребовать модернизации действующих электрических систем – ИБП, батарей, распределительных устройств и генераторов. Это дорого и сопряжено с операционными рисками. Но без этого для установки более мощного ИТ-оборудования понадобится больше пространства. По прогнозам, через несколько лет четверть стойки с такими серверами будет потреблять 10 кВт.

Новые ЦОДы проектировщики могут оптимизировать для значительно более высокой плотности мощности. Однако покупка дорогостоящего электрооборудования сопряжена с экономическим риском, если только не предусмотреть гибкое управление ресурсами (например, за счет использования модульных систем высокой заводской готовности).

Потребности в плотности энергопотребления на ближайшие 10–15 лет пока сложно точно спрогнозировать. Достигнет ли средняя мощность ИТ-стойки к концу десятилетия 10, 20 или даже 30 кВт? Даже самые информированные эксперты могут лишь строить догадки.

Управление температурным режимом тоже усложняется. Многие «традиционные» установки неспособны подавать поток воздуха, необходимый для охлаждения ИТ-систем высокой плотности. Более того, для обеспечения относительно низких температур, которые обычно требуются для стоек с высокой плотностью и серверов следующего поколения, нужны более мощные системы охлаждения. А повышение температуры чревато минимум потерей производительности (современные микросхемы снижают производительность при повышении температуры). Поэтому ASHRAE рекомендует выделять зоны с низкой температурой, чтобы свести к минимуму воздействие на энергоэффективность объектов.

Все больше ЦОДов рассматривают возможность использования прямого жидкостного охлаждения (DLC). Несмотря на то что методы разработки и эксплуатации DLC «повзрослели» и на рынке имеется множество вариантов (холодные пластины или погружение), внедрение таких систем сопряжено с рядом проблем. Отсутствие стандартов повышает риски зависимости от одного вендора и перебоев в поставках ключевых компонентов, а также ограничивает выбор конфигураций серверов. Кроме того, большая часть корпоративной ИТ-инфраструктуры (главным образом системы хранения данных и сетевое оборудование) сегодня не могут охлаждаться жидкостями.

Хотя количество моделей серверов с интегрированными системами DLC увеличилось, переход на DLC требует массовой закупки такого ИТ-оборудования. При работе с несколькими поставщиками DLC, у каждого из которых свой набор требований, команды эксплуатации могут столкнуться с технической фрагментацией объектов. А проектировщикам ЦОДов придется планировать не только поддержку рабочих нагрузок со смешанной плотностью, но и более разнородную техническую среду. Сегодня вряд ли многие сотрудники ЦОДов знакомы с деталями процедур обслуживания DLC-систем, особенно систем погружного типа, что подчеркивает важность обучения и отработки процедур эксплуатации. В такой среде вероятность ошибок, связанных с человеческим фактором, только возрастет.

Предстоящие изменения в ИТ-системах ЦОДов будут очень серьезными. В основе этих перемен лежит физика полупроводников, но их движущей силой является экономика инфраструктуры: более мощные чипы, как правило, помогают повысить эффективность инфраструктуры и благодаря приложениям, которые на них выполняются, создают большую ценность для бизнеса. Для операторов ЦОДов откроется множество возможностей получить преимущества над конкурентами, но не без определенного риска. В дальнейшем ключевым фактором станет адаптивность.

|

Энди Лоуренс, исполнительный директор по исследованиям;

Ронда Асьерто, вице-президент по исследованиям;

Дэниел Бизо, директор по исследованиям;

Оуэн Роджерс, директор по исследованиям в области облаков;

Жаклин Дэвис, аналитик-исследователь;

Макс Смолакс, аналитик-исследователь;

Ленни Саймон, старший научный сотрудник;

Дуглас Доннеллан, старший научный сотрудник, Uptime Institute Intelligence

Печатается с разрешения Uptime

Institute.

Заметили неточность или опечатку в тексте? Выделите её мышкой и нажмите: Ctrl + Enter. Спасибо!