| Рубрикатор |  |

|

| Статьи |  |

ИКС № 2 2022 |  |

|

| Алексей ЖУМЫКИН | 28 июня 2022 |

Легенды и мифы датацентров

В этой главе я хотел бы рассказать о нескольких «проблемах», с которыми привыкли бороться строители и эксплуатационщики датацентров, но которые на самом деле проблемами не являются. Часто обсуждения этих вопросов вызывают нешуточные и эмоциональные споры, но моя задача показать, что они могут иметь простое решение.

Поддержание температуры

Существует устойчивое мнение, что серверное оборудование должно эксплуатироваться в строго определенных границах температуры и влажности. Каждый человек, знакомый с датацентрами, хоть раз видел таблицу американского сообщества ASHRAE. Но так ли она нужна на самом деле? Давайте рассмотрим формулу теплопроводности из курса термодинамики:

Qt = G × C × ΔT

Здесь

Qt = Q × t – количество тепла, переносимое за единицу времени

G – объем воздуха

С – теплоемкость воздуха

ΔT – разница температур охлаждаемого тела и охлаждающего воздуха.

Из этой формулы видно, что можно охлаждать стойки путем регулирования разницы температур. Однако ясно, что, во-первых, диапазон изменения температур внутри сервера больше, чем диапазон изменения температуры подаваемого воздуха, поэтому для обеспечения теплообмена все равно нужно изменять скорость потока. Чаще всего такими расчетами никто не утруждается, и скорость вращения вентиляторов выбирается с запасом заведомо выше требуемого. Ни о какой энергоэффективности системы в таком случае речь идти не может.

Во-вторых, вентиляторы в канале охлаждения есть всегда (очевидно, что при G=0 охлаждения не будет), поэтому увеличение скорости их вращения будет стоить значительно меньше капитальных и операционных затрат, чем построение громоздкой системы охлаждения.

Также из формулы видно, что, если температура охлаждающего воздуха хоть чуточку ниже охлаждаемого объекта – охлаждение все еще возможно, однако потребуется значительный объем воздуха. То есть теоретически можно охлаждать процессоры, нагретые до 90°С, воздухом с температурой в 60–70°С, но скорость воздуха будет запредельной.

Поэтому самый правильный путь – построить систему охлаждения, при которой мы будем регулировать только скорость вращения вентиляторов. Так как нагрузкой в нашем датацентре могут выступать серверы от сторонних производителей, в которых скорость вращения вентиляторов не регулируется, достаточно будет обеспечить для них ровно тот объем воздуха, который они потребляют. Как мы обсуждали раньше, в идеальном случае нужно провести лабораторные испытания каждого сервера или стойки в сборе, но практически можно справиться и более простым способом.

Давайте разберем структурную схему такой системы охлаждения поподробнее.

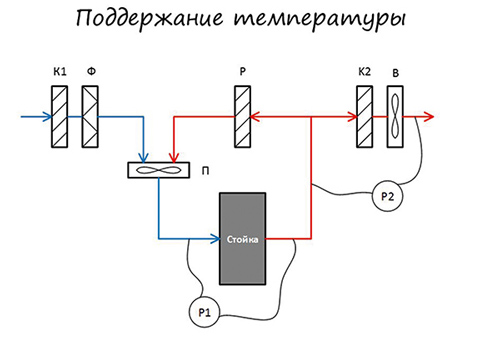

На рисунке видно, что входящий воздух проходит через приточный клапан К1 и фильтровальную стену Ф, поступает на приточные вентиляторы П, проходит через серверную стойку, где нагревается и либо поступает сразу на вытяжные клапаны К2 и вентиляторы в теплое время года, либо через рециркуляционные клапаны Р смешивается с приточным холодным воздухом для поддержания комфортной температуры.

Для того чтобы серверы в стойке могли работать на полную мощность, необходимо убедиться, что к передней дверце стойки поступает достаточное для охлаждения количество воздуха. Для этого можно измерить разницу давлений между холодным и горячим коридором (Р1) и поддерживать ее на постоянном уровне, меняя скорость приточных вентиляторов. Таким образом, чем больше будет потребление стойки, тем сильнее будут раскручиваться вентиляторы серверов и, соответственно, сильнее будут раскручиваться вентиляторы приточных установок. Также будет работать система и при росте температуры уличного воздуха.

В принципе, воздух из горячего коридора может удаляться и самотеком через выпускные клапана (К1), однако при большом количестве стоек объем горячего воздуха может создавать высокое давление в горячем коридоре. Поэтому разумно установить вытяжные вентиляторы, работающие на уменьшение разности давления P2 между горячим коридором и улицей.

Какую температуру можно выбрать в качестве комфортной? Со стороны низких температур следует свериться со спецификациями компонентов серверов. Как правило, современные компоненты серверного оборудования могут работать при температурах чуть выше нуля без существенного сокращения срока службы, поэтому можно было бы «захолаживать» зал как можно сильнее – это было бы экономически выгодно. С другой стороны, какие-то операции в серверных помещениях будут производиться персоналом датацентра, поэтому стоит поддерживать температуру, при которой можно комфортно находиться в помещении и выполнять рабочие задачи. Например, температуру не ниже 18–20°С.

Для определения верхней границы нужно понимать, что серверы в стойке могут нагревать воздух на 15–20 градусов, и таким образом температура в горячем коридоре может достигать значений, при которых строительные конструкции начнут терять свои свойства. В реалиях нашей страны уличная температура может превышать 40°С, что приведет к температуре в горячем коридоре до 60°С. В принципе, если серверная построена с устойчивостью к таким температурам, то практического ограничения сверху у нас нет.

Описанная схема доказала свою практическую эффективность и запатентована в России (патент RU 269 20 46), но большинство инженеров российских датацентров по-прежнему ориентируются на графики ASHRAE. Когда соблюдения условий, рекомендуемых какой-то ассоциацией из Америки, требуют клиенты и переубедить их не представляется возможным, наверное, остается только развести руками и выполнять. Так же можно прописать, чтобы все сотрудники датацентра ходили в балетных пачках, – если клиент готов за это платить, то почему бы и нет. Но для своих собственных датацентров или тех, где клиентам предоставляются мощности под облачные решения, стоит серьезно задуматься: зачем делать дорого и громоздко, если можно сделать просто, дешево и надежно?

Влажность

Еще одним мифом, происходящим из чтения спецификаций без понимания физической сути процессов, является «поддержание требуемой влажности в датацентре». Давайте разберем, что стоит за этим мифом.

Когда я спрашиваю коллег, чем страшна низкая влажность, мне все время отвечают, что сухой воздух ведет к образованию статического электричества, которое будет выводить серверное оборудование из строя. С одной стороны, предпосылки к таким опасениям есть. Подростком, занимаясь конструированием электронных игрушек на письменном столе, мне приходилось по неаккуратности сжигать КМОП-микросхемы прикосновением руки. Однако в современной промышленной среде достаточно убедиться в исправности заземляющих контуров, чтобы снизить вероятность повреждения статикой до нуля. Не скажу за всю индустрию, но мне не известен ни один (!) случай, когда в датацентре без контроля влажности статическим электричеством было повреждено оборудование.

Другой крайностью может быть слишком высокая влажность. С ней связана фобия того, что высокое содержание воды в воздухе может привести к образованию капель на оборудовании и соответствующим замыканиям и другим ужасным последствиям. Однако, если разобраться в определении точки росы и вспомнить эксперимент по вытаскиванию бутылки водки из морозилки, то можно убедиться, что роса выпадает при попадании теплого воздуха с высокой влажностью на холодный предмет. В случае датацентра мы практически всегда имеем ситуацию, когда холодный воздух сталкивается с нагретым оборудованием и его температура постепенно повышается. Тем самым образование росы в условиях правильно спроектированного серверного помещения физически невозможно.

Нужно отметить, что контроль за влажностью все же необходим в тех случаях, когда система работает на фрикулинге с доохлаждением. При переходе на такой режим из прямого фрикулинга теплый воздух с улицы действительно будет соприкасаться с холодными поверхностями теплообменников. В таком случае нужно внимательно выбрать режимы работы системы охлаждения и не допускать приближения к точке росы. Естественно, в этом случае стоит задуматься о правильной гидроизоляции прилегающих к вентустановкам помещений.

Примером полезного использования влажности может быть адиабатическое охлаждение, принцип которого заключается в понижении температуры входящего воздуха путем распыления микроскопических капель пара. Таким образом в некоторых случаях можно добиться понижения температуры на 5–6 градусов. Однако следует помнить и об ограничениях: если влажность уличного воздуха уже довольно высока (за окном редкая тропическая жара), то такой способ не сработает. Очевидно, что для рециркуляции он тоже не подходит, по той же причине. Кроме того, системы адиабатического охлаждения требуют для работы специально очищенную воду и весьма капризны в обслуживании. В итоге целесообразность их применения вызывает вопросы.

Пыль

Однажды мне довелось познакомиться с Миккой Первила, необычным аспирантом Хельсинкского университета имени Алвара Аалто, который разместил на крыше здания своей кафедры стойку с серверным оборудованием и эксплуатировал ее в самых настоящих условиях фрикулинга. Позади стойки он соорудил небольшую, метра два на три, теплицу, в которой круглогодично выращивал красные перцы. Собственно, это был самый настоящий пример использования тепла серверов, которым только через несколько лет стали заниматься большие датацентры.

Но самым впечатляющим было то, что Микко вообще не заботился о фильтрации воздуха для своей стойки. Вы можете сами в этом убедиться, найдя в сети видео с названием Snow is not a problem for servers in Finland. По словам экспериментатора, проект длился полтора года, после чего в серверах стали выходить из строя вентиляторы, а производитель отказался их заменять, и Микко в условиях ограниченного финансирования был вынужден свернуть стойку. Стойку эту в работе я видел собственными глазами и даже получил в подарок один из выросших перчиков.

История эта о том, что зачастую оборудование может работать в гораздо более тяжелых условиях без каких-либо проблем. Это совсем не значит, что нужно полностью пренебрегать уходом за оборудованием. Просто можно найти тот практический минимум заботы, которого достаточно для безаварийной работы.

Работа с фрикулингом не может обойтись без того, что маленькие частички пыли будут попадать в серверные помещения. Кроме того, если вентиляционные установки используют приводные ремни, то в этой пыли будут содержаться и вкрапления резины. Это приводит к тому, что через некоторое время серверы и стойки покрываются серым налетом и выглядят, скажем так, неухоженно. Если продажа красивых картинок с изображениями оборудования датацентров является частью вашего бизнеса, вы можете расценить это как катастрофу. На самом деле практика показывает, что в пределах срока эксплуатации серверов запыленность не оказывает никакого влияния на их отказоустойчивость. Но выглядеть может, конечно, неаккуратно.

Не побоюсь даже высказать мнение, что использование бахил и липких ковриков в серверных является скорее маркетинговым инструментом, показывающим клиентам, как компания заботится о сохранности их оборудования. Однажды я организовывал реальные измерения уровня запыленности на площадках, среди которых были помещения и с фрикулингом, и с классическими системами охлаждения. На некоторых объектах в мониторинг добавлялись постоянно действующие датчики запыленности. Результаты показали, что минимальные требования по чистоте вполне обеспечивают соответствие требованиям ГОСТа к чистоте компьютерных залов.

Пожалуй, единственное место, где с пылью стоит быть по-настоящему внимательным, – это оптические разъемы сетевого оборудования. Пыль действительно влияет на качество передачи сигнала. Поэтому стоит держать неиспользуемые разъемы закрытыми специальными колпачками, а при соединениях продувать сжатым воздухом из баллончика.

Еще раз повторю, что сказанное выше не означает наплевательского отношения к чистоте в помещениях и отсутствие регулярной уборки. Я говорю о том, что при организации уборки обязательно нужно включать здравый смысл. Не очень частая влажная уборка и своевременная замена фильтров уже могут быть достаточными мероприятиями для достижения чистоты.

Пожаротушение

Начнем с самого главного: построить и эксплуатировать датацентр без системы пожаротушения в серверных возможно. Но перед тем, как сделать это, нужно самому искренне верить, что пожара в нем быть не может. В худшем случае возможно задымление и возгорание, скажем, блока питания в сервере или какого-нибудь компонента электрической системы, но в отсутствие поддерживающих горение материалов такое возгорание затухает самостоятельно. С другой стороны, известна масса случаев, когда ложный запуск систем пожаротушения приводил к несопоставимо большему урону для площадки, нежели выгорание блока питания.

Если говорить коротко, то законодательство требует обеспечить сохранность жизни людей, а не собственности. Таким образом, если все люди спасены, то здание может сгореть дотла: пожарные бригады будут только следить, чтобы огонь не распространялся на соседние участки. При этом то, что не сгорит, все равно будет залито пеной, так что эксплуатировать дальше ничего не удастся. Для того, чтобы персонал успел покинуть здание, необходимо обеспечить три условия:

- Своевременное обнаружение возгорания

- Эффективное оповещение персонала

- Достаточное количество коротких путей эвакуации из любой точки.

Вместе с демонстрацией выполнения этих условий необходимо произвести расчет огнестойкости здания в проекте. После согласования проекта в соответствующих министерствах застройщик получает специальные технические условия (СТУ), по которым можно выполнять проект.

Пока что такой путь все еще очень необычен для нашей страны, и это понятно. Собственники зданий предпочитают перестраховаться, проектные организации и продавцы систем пожаротушения, а также специальные компании, с лицензиями на обслуживание систем пожаротушения, вряд ли станут отговаривать заказчика от установки самой современной и дорогой системы.

Есть еще один фактор, который следует принимать во внимание, если вы задумались об отказе от пожаротушения: страхование объекта. Вы должны быть готовы к тому, что андеррайтерам страховой компании такое решение может не понравиться, и вам могут вообще отказать в страховании, либо страховая премия будет намного выше.

Подводя итог: эта глава была написана не для того, чтобы уговорить вас строить датацентры по-новому. Я прекрасно понимаю, что большинство не решится из-за страха, лени или потому, что остальные тоже делают «как всегда», иногда решаясь только перейти от одного производителя к другому, поменяв шило на мыло, всерьез и с серьезным видом обсуждая аргументы «за» и «против» такого перехода. Эта глава была призвана показать, что по-другому все-таки можно. Это обосновано и доказано на практике.

Из книги Алексея Жумыкина «Настольная книга эксплуататора». Издатель: компания 3data.

Орфография и стилистические особенности оригинала

сохранены.

Заметили неточность или опечатку в тексте? Выделите её мышкой и нажмите: Ctrl + Enter. Спасибо!