| Рубрикатор |  |

|

| Статьи |  |

ИКС № 4 2022 |  |

|

| Дэниел БИЗО Ленни САЙМОН Жаклин ДЭВИС | 31 октября 2022 |

Прямое жидкостное охлаждение: переход неизбежен

Изменения как в технических, так и в бизнес-требованиях подталкивают операторов ЦОДов к переходу на прямое жидкостное охлаждение.

До его широкомасштабного внедрения предстоит преодолеть массу

препятствий, но многие в отрасли полагают, что это лишь вопрос времени.

Охлаждение остается основной причиной неэффективности ЦОДов, поскольку на него расходуется много не только энергии, но и денег – на дорогостоящее оборудование. Между тем, после периода инноваций, в том числе оптимизации воздушных потоков и внедрения бескомпрессорных режимов отвода тепла, повышение эффективности охлаждения затормозилось. Согласно «Глобальному исследованию дата-центров», проведенному Uptime Institute в 2021 г., коэффициент энергоэффективности (PUE) в отрасли составляет 1,57 – это значительно ниже, чем 1,98 в 2011 г., но лишь немногим лучше рекордно низкого показателя 2018 г. – 1,58.

Прямое жидкостное охлаждение (Direct Liquid Cooling, DLC) – это совокупность методов, позволяющих отводить тепло от ИТ-электроники путем циркуляции жидкого хладагента. До недавнего времени применение жидкостного охлаждения ограничивалось в основном приложениями в области высокопроизводительных вычислений. Для таких вычислений характерны чрезвычайно высокая плотность инфраструктуры и высокоскоростные соединения между вычислительными узлами. В крупномасштабной ИТ-инфраструктуре DLC используют лишь отдельные ЦОДы, среди них – французский OVHcloud. В целом же даже в новых ЦОДах придерживаются воздушного охлаждения, поскольку оно хорошо изучено и в большинстве случаев достаточно эффективно.

Эксперты Uptime Institute Intelligence полагают, что скоро баланс сместится в сторону DLC. После многочисленных фальстартов и задержек проектов крупных операторов интерес к прямому жидкостному охлаждению вновь усилился. Приложения, требующие высокоплотной инфраструктуры, распространяются все шире и становятся все более масштабными. К ним относятся аналитика на основе больших данных и быстро развивающиеся глубокие нейронные сети. Кроме того, от ЦОДов требуют дальнейшего роста эффективности и повышения экологичности, а резервы повышения эффективности воздушного охлаждения практически исчерпаны. По оценкам, даже максимально оптимизированные объекты тратят на воздушное охлаждение и сопутствующие потери не менее 15–20% энергии.

Похоже, что именно эволюция микроэлектроники для ЦОДов подтолкнет их операторов к массовому переходу на DLC. Мощность серверных чипов и, следовательно, мощность серверов будет расти. И речь идет не об отдаленном будущем. В Uptime Institute ожидают, что уже во второй половине 2020-х гг. повышение плотности и мощности массовых серверов и кремниевых микросхем постепенно сделает воздушное охлаждение непрактичным и даже убыточным как по капитальным, так и по операционным затратам.

Однако переход на прямое жидкостное охлаждение, несмотря на очевидную потребность в нем, осложняется рядом технических и экономических препятствий. В основе проблем – отсутствие стандартов на рынке DLC. В отличие от воздушного охлаждения, где воздух выступает и в качестве стандартной охлаждающей среды, и в качестве естественной границы между системами охлаждения и ИТ-системами, в жидкостном не существует аналогичного стандартного хладагента или границы.

Вендоры недостаточно координируют свои разработки DLC-платформ, в результате на рынке присутствует множество несовместимых систем с поддержкой от разных поставщиков ИТ-оборудования. В отсутствие стратегического подхода к созданию стандартов DLC, ЦОДам, возможно, придется применять несколько систем прямого жидкостного охлаждения, каждая со своими особенностями и ограниченной совместимостью, что увеличит эксплуатационные расходы и риски.

Впрочем, за последние годы системы DLC претерпели существенные изменения, их стало проще внедрять и эксплуатировать. Растущее количество инсталляций DLC дает поставщикам необходимую информацию для разработки более надежных, простых в использовании и совместимых по материалам продуктов.

Чтобы выяснить точку зрения игроков отрасли на DLC, эксперты Uptime Institute Intelligence в декабре 2021 г. – январе 2022 г. провели глобальный онлайн-опрос владельцев/операторов ЦОДов, их ИТ-менеджеров, а также проектировщиков ЦОДов и инженерных систем, консалтинговые фирмы и поставщиков продуктов и услуг. В опросе Direct Liquid Cooling Survey 2022 приняли участие 197 операторов корпоративных ЦОДов.

Типы технологий DLC

Мы определяем DLC как широкую категорию методов, в которых охлаждающая жидкость подается к компонентам ИТ-системы (процессорам, памяти и другой электронике) для отвода тепла. Отвод может производиться как через радиаторы, так и при прямом контакте. Мы не будем касаться других систем, подающих жидкости в стойку (например, теплообменников на двери), поскольку в качестве промежуточной среды передачи тепла от ИТ-электроники к инфраструктуре охлаждения они используют воздух. Это не формальное разделение: технические и эксплуатационные характеристики таких систем существенно различаются.

В настоящем исследовании мы рассматриваем шесть основных типов технологических платформ DLC, которые делятся на две категории: построенные на базе охлаждающих пластин и иммерсионные (погружные) системы.

Системы с охлаждающей пластиной

Существуют три типа систем DLC с охлаждающей пластиной:

- Пластины с водяным охлаждением. Очищенная вода, деионизированная вода или водно-гликолевая смесь циркулирует через охлаждающие пластины по замкнутому контуру для отвода тепла от самых мощных (и самых горячих) компонентов – центрального и графических процессоров (или других ускорителей) и модулей памяти. Как правило, охлаждающие пластины поглощают 70–80% общей тепловой нагрузки сервера в зависимости от конфигурации и интенсивности его работы. Системы водяного охлаждения получили наибольшее распространение, поскольку давно используются в высокопроизводительных вычислениях, но в некоторых ЦОДах все еще опасаются утечек в ходе эксплуатации.

- Охлаждающие пластины с однофазным диэлектрическим хладагентом. В этих пластинах вместо воды в качестве теплоносителя используется специальная диэлектрическая жидкость. Протечка такой жидкости не приведет к повреждению электроники, а ее инертность означает отсутствие коррозии внутренних материалов контура (охлаждающей пластины или теплообменника). По сравнению с водой эти жидкости имеют меньшую удельную теплоемкость, поэтому для той же холодопроизводительности нужна более высокая скорость потока, чем в пластинах с водяным охлаждением, что требует более высокого давления. Это относительно новое решение с ограниченным опытом эксплуатации.

- Охлаждающие пластины с двухфазным диэлектрическим хладагентом. Диэлектрический хладагент закипает при относительно низких температурах (например, ниже 49°C) в камере охлаждающей пластины. Испаряющийся теплоноситель выводится из сервера по шлангам и проходит через конденсатор для рециркуляции. Большое количество энергии, поглощаемой при фазовом переходе (кипении и испарении), обеспечивает необходимую холодопроизводительность. Этот вариант лишь недавно стал доступен, но вызывает большой интерес в силу высокой эффективности, низких рисков и относительной простоты внедрения.

Иммерсионные системы

Существуют также три типа иммерсионных (погружных) систем DLC:

- Погружное шасси (однофазное). Каждый сервер заключен в герметичный, автономный корпус. Иногда несколько компактных серверных узлов устанавливаются в одно шасси. Внутри корпуса компоненты частично или полностью погружены в диэлектрическую жидкость. При частичном погружении хладагент сначала доставляется к основным компонентам (процессорам, ускорителям и модулям памяти). Затем жидкость перетекает на серверную плату для охлаждения другой маломощной электроники. Ключевая особенность всех систем с погружным шасси – возможность их интеграции в стандартные вертикальные стойки, часть которых может охлаждаться типовыми системами воздушного охлаждения.

- Погружение в ванну (однофазное). ИТ-системы погружены в резервуар с диэлектрическим хладагентом, который находится в состоянии принудительной либо естественной конвекции, когда более теплая жидкость поднимается вверх. Охлаждение основано на способности жидкости поглощать тепловую энергию, зависящей от того, насколько хорошо хладагент рассеивает тепло и как быстро он обтекает охлаждаемые компоненты. Большинство производителей иммерсионных систем выбирают однофазный хладагент в силу его доступности, незначительного влияния на глобальное потепление, низкой стоимости и простоты внедрения.

- Погружение в ванну (двухфазное). Серверы погружены в герметичный резервуар, заполненный диэлектрическим хладагентом, который кипит при относительно низкой температуре (например, 49°C) и при атмосферном давлении. Испаряясь, охлаждающая жидкость поглощает тепло ИТ-компонентов и как пар поднимается в конденсатор в верхней части резервуара, где конденсируется в жидкость и рециркулирует. Эксперты Uptime считают этот тип системы охлаждения наиболее подходящим для крупномасштабного использования, поскольку он обеспечивает высокую эффективность охлаждения, полностью поглощая тепловую нагрузку. Недостатки – проблемы с совместимостью материалов, высокая стоимость диэлектрической жидкости и ее потери из-за утечек.

В Uptime считают, что методы прямого жидкостного охлаждения будут совершенствоваться по мере удовлетворения требований клиентов и решения технических задач благодаря инновациям, стирающим границы между описанными выше подходами.

Экономическая выгода использования DLC не всегда очевидна. Способность жидкости отводить тепло намного выше, чем у воздуха, однако прямое жидкостное охлаждение применяется в очень немногих ЦОДах. Рассмотрим основные аргументы за и против DLC.

Стимулы и преимущества

Самый распространенный аргумент в пользу DLC, который приводят сегодня те, кто использует прямое жидкостное охлаждение, – необходимость поддерживать работу стоек высокой плотности. Но со временем станут важны и другие факторы. Четыре из них описаны ниже в порядке актуальности: от тех, с которыми придется считаться совсем скоро, до более отдаленных во времени.

Распространение высокопроизводительных приложений

Высокопроизводительные приложения и системы высокой плотности, которые их обслуживают, используются все чаще. Более трети предприятий, принявших участие в нашем опросе, уже имеют ИТ-стойки мощностью более 20 кВт, почти каждое четвертое – мощностью более 30 кВт, а в каждом десятом работают несколько стоек мощностью более 60 кВт (рис. 1). И респонденты нашего опроса ожидают, что в будущем пиковая мощность их стоек возрастет. Примеры высокопроизводительных приложений: аналитика в реальном времени; транскодирование мультимедиа; облачные игры; инженерное моделирование; обучение сложных моделей искусственного интеллекта/машинное обучение на больших данных.

Источник: Uptime Institute Intelligence

Рис. 1. Распределение максимальной мощности серверных стоек в ЦОДах

Охлаждение серверных чипов нового поколения

Серверные процессоры (ЦПУ и ускорители разных типов) будут потреблять все больше энергии и рассеивать все больше тепла. С каждым следующим технологическим поколением электронные цепи становятся все компактнее и мощнее. Поэтому увеличение плотности теплового потока (мощности на единицу площади) неизбежно. В предыдущее десятилетие ЦОДы уже столкнулись с тем, что типичная расчетная тепловая мощность процессора выросла примерно со 100 до 200 Вт, а в 2020-х гг. мы ожидаем усиления этой тенденции: трех- или даже четырехкратного увеличения до более чем 600 Вт.

Отчасти из-за роста потребляемой мощности, отчасти из-за интеграции микросхем памяти в корпус процессора с более низкими пределами рабочих температур, для чипов следующих поколений максимальная допустимая температура, измеренная на корпусе процессора, будет значительно ниже, что создаст дополнительную проблему для охлаждения серверов. Информация, собранная Uptime, показывает, что все больше серверных продуктов будут иметь пониженные максимальные рабочие температуры, иногда до 55–60°C. Это намного ниже текущей нормы 70–90°C.

Первые высокомощные и низкотемпературные серверные процессоры, скорее всего, появятся во второй половине 2022 г. Хотя поначалу они будут редкостью и будут использоваться в основном в суперкомпьютерах, мы ожидаем, что чипы такой конструкции станут обычным явлением во многих ЦОДах уже ко второй половине нынешнего десятилетия. Кроме того, с экономической точки зрения серверы, способные нести большую полезную нагрузку, предпочтительнее. В сочетании с необходимостью повышения производительности для отдельных бизнес- и технических приложений это создаст массовый спрос на такие процессоры со сложными тепловыми характеристиками. Дата-центры, которые не смогут работать с системами следующего поколения из-за их требований к охлаждению, поставят под угрозу свою конкурентоспособность по сравнению с организациями, которые обеспечат их поддержку.

Экологическая устойчивость

Общепринятые лучшие практики работы с воздушным охлаждением в ЦОДах оставляют мало возможностей для еще более эффективного использования энергии и воды. DLC предлагает снижение энергопотребления и одновременно почти полностью устраняет потребность в воде для охлаждения. Однако это не происходит автоматически и зависит от вариантов реализации и климатических условий на объекте.

Широкомасштабное внедрение DLC может также повысить экологическую устойчивость дата-центров, открывая возможности для реализации новых схем повторного использования тепла. Без более широкого внедрения DLC общие показатели экологической устойчивости ЦОДов через несколько лет могут даже ухудшиться. Для некоторых будущих высокоплотных ИТ-систем рекомендуемая температура приточного воздуха будет снижена, что не позволит рассчитывать на системы охлаждения без чиллеров. Рекомендации ASHRAE по тепловому режиму в средах с оборудованием для обработки данных от 2021 г. не оставляют сомнений на этот счет.

Операционные расходы и капитальные затраты

Для многих предприятий, рассматривающих возможность перехода на DLC, главный аргумент – высокий потенциал повышения энергоэффективности. Частичный коэффициент энергоффективности pPUE для систем прямого жидкостного охлаждения может составлять 1,02–1,03 при работе на повышенных температурах охлаждающей жидкости. DLC также экономит энергию благодаря отказу от вентиляторов в ИТ-системах и уменьшению потерь из-за статического электричества в кристаллах микросхем.

У DLC есть большой потенциал и для снижения капитальных затрат. Типичный ЦОД с воздушным охлаждением расходует приблизительно 25–35% общей мощности на обеспечение пиковой мощности и охлаждение. Эта мощность также должна поддерживаться генераторными установками, что требует больших капитальных и эксплуатационных затрат. Резерв мощности может быть существенно меньше, если на объекте используется в основном DLC. А в случае повышения ИТ-потребностей высвобождение резервов энергии вследствие перехода на жидкостное охлаждение поможет отсрочить капитальные вложения в уже эксплуатирующийся ЦОД или даже избежать их.

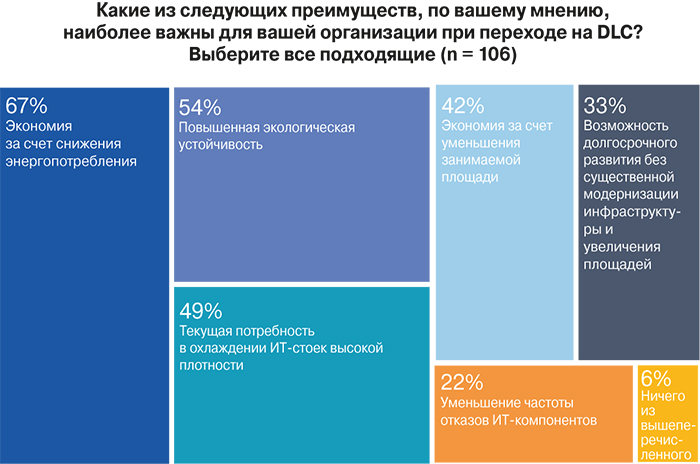

Наш опрос показал, что для предприятий, еще не использующих DLC, важнейшие аргументы перехода на прямое жидкостное охлаждение, – экономия средств за счет снижения энергопотребления и повышение экологичности (рис. 2). По важности они опережают потребность в охлаждении ИТ-стоек с высокой плотностью размещения. Потенциальная экономия за счет уменьшения физической площади инфраструктуры также важный довод в пользу DLC.

Источник: Uptime Institute Intelligence

Рис. 2. Стимулы перехода на DLC

Барьеры и препятствия

Основная причина ограниченного распространения прямого жидкостного охлаждения – отсутствие стандартов для этой технологии. Работы в этом направлении ведутся, прежде всего в рамках Open Compute Project, но потребуются годы, чтобы они принесли плоды. И даже после утверждения стандарты повлияют лишь на часть рынка. Пока же стандартов нет, при развертывании систем DLC возникает целый ряд проблем.

Совместимость материалов

Все компоненты, контактирующие с охлаждающей жидкостью, будь то очищенная вода, водно-гликолевые смеси или технические жидкости, должны быть тщательно проверены на совместимость. Сегодня блоки распределения охлаждающей жидкости (CDU) подходят только к конкретным системам DLC, и поэтому ЦОДы часто оказываются привязаны к одному или нескольким поставщикам. Совместимость особенно важна для иммерсионных систем, в которых ИТ-платы погружаются в жидкость и любое отклонение от заданных параметров может привести к неожиданным последствиям.

Несмотря на простоту, тщательное тестирование множества доступных комбинаций может потребовать значительного времени (часто – месяцев), организационных ресурсов и денег. Некоторые проблемы совместимости материалов проявляются не в виде явных отказов компонентов, а в виде неустойчивой работы, к примеру, падения производительности из-за потери целостности сигнала.

Поддержка ИТ-оборудования

Вендоры ИТ-оборудования не обеспечивают столь же полной поддержки систем жидкостного охлаждения, как воздушного. Иногда поставщики серверов предлагают системы DLC, интегрированные с ИТ-оборудованием, но обычно с очень узким выбором вариантов аппаратного обеспечения. Системы DLC третьих производителей поддерживаются, как правило, в индивидуальном порядке. Если заказчик или его партнер-поставщик осуществляют интеграцию без явного согласия производителя ИТ-оборудования, гарантия на оборудование аннулируется.

Однако ситуация начинает меняться. Сформировалась небольшая, но растущая сеть партнерств между крупными поставщиками ИТ-оборудования и поставщиками систем DLC. Некоторые крупные системные интеграторы в настоящее время предлагают гарантии на ИТ-оборудование для более широкого спектра систем DLC, чем его производители.

Техническое обслуживание и эксплуатация

Для работы с системами DLC требуется переподготовка персонала. Кроме того, необходимо обновить процедуры технического обслуживания и эксплуатации для сотрудников, отвечающих и за инженерные, и за ИТ-системы. Обязанности по обслуживанию и эксплуатации систем прямого жидкостного охлаждения должны быть четко разделены. Важно определить, кто отвечает за блоки CDU – инженерная или ИТ-команда, а также установить регламент обслуживания ИТ-оборудования, охлаждаемого DLC-системой. Риски здесь повышаются из-за возможной утечки воды или диэлектрической жидкости.

Работа с системами на базе охлаждающих пластин не вызывает затруднений у опытных сотрудников, а вот погружение для большинства персонала ЦОДов процесс необычный, особенно если это погружение в резервуары с кипящими хладагентами. Переобучение персонала требует времени и денег, хотя это ценная инвестиция. Но даже при обученном персонале внедрение современных систем DLC повышает эксплуатационные риски из-за относительно низкой зрелости процедур и может привести к более высокому, чем обычно, числу сбоев и неполадок.

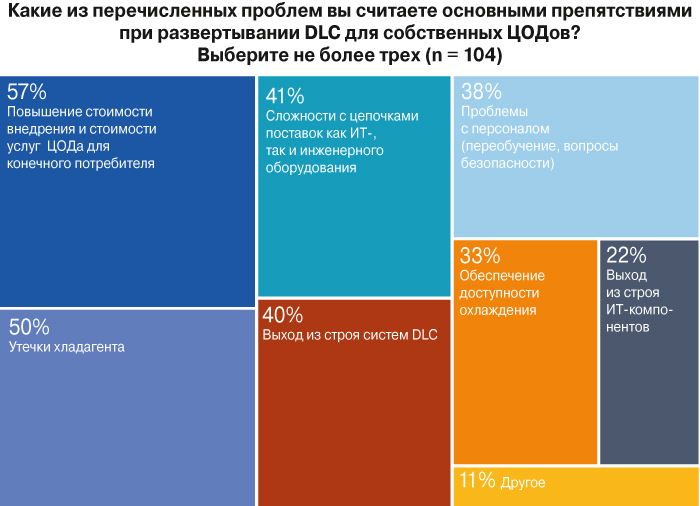

Первоначальная стоимость внедрения

Все вышеупомянутые факторы могут означать значительные затраты. Стоимость масштабного развертывания систем DLC увеличивают также расходы на сборку ИТ-систем на заказ и дополнительное оборудование охлаждения (блоки CDU, трубопроводы, новые стойки, а в случае иммерсионных систем – резервуары и диэлектрические жидкости, весьма дорогие для двухфазных систем). Стоимость внедрения чаще всего называется операторами ЦОДов главным препятствием перехода на жидкостные системы охлаждения, опережая опасения относительно утечек (рис. 3). Эти затраты могут быть компенсированы при строительстве нового дата-центра или при наращивании мощностей за счет экономии на капиталовложениях в инфраструктуру воздушного охлаждения, в недвижимость и/или за счет уплотнения ИТ-оборудования.

Источник: Uptime Institute Intelligence

Рис. 3. Основные препятствия к внедрению DLC

DLC сегодня и через пять лет

Из принявших участие в нашем опросе почти 200 операторов корпоративных ЦОДов примерно каждый шестой в настоящее время использует прямое жидкостное охлаждение (рис. 4). Почти две трети респондентов заявили, что намерены рассмотреть возможность применения DLC в своей инфраструктуре. Пятая часть не готова к использованию DLC по разным причинам – от отсутствия ожидаемой потребности в высокоплотных ИТ-мощностях и достаточной производительности существующих систем воздушного охлаждения до нежелания подводить к серверам трубы с водой.

Источник: Uptime Institute Intelligence

Рис. 4. Использование DLC сегодня и в будущем

Отвечая на вопрос о возможном использовании DLC в течение пяти ближайших лет, большинство респондентов прогнозируют, что по крайней мере 10% их стоек будут оснащены прямым жидкостным охлаждением, и лишь каждый шестой не ожидает появления в своих ЦОДах стоек с DLC. Выделяется также небольшая группа с повышенными амбициями: каждый десятый прогнозирует, что их ИТ-инфраструктура практически полностью перейдет на жидкостное охлаждение в течение пяти лет (рис. 5).

Источник: Uptime Institute Intelligence

Рис. 5. Ожидаемая доля ИТ-стоек с DLC в течение пяти лет

Самый популярный тип DLC, возможность внедрения которого рассматривают предприятия, – это охлаждающие пластины с водой или водно-гликолевыми жидкостями. Это объясняется, по всей вероятности, тем, что такие системы широко доступны и наиболее понятны в эксплуатации (рис. 6). Вторым наиболее подходящим вариантом считаются охлаждающие пластины с диэлектрическими хладагентами, хотя они появились относительно недавно. Иммерсионные системы выбрало небольшое количество участников опроса, что можно объяснить масштабами изменений, которые повлечет их внедрение в проекты ЦОДов, цепочки поставок и эксплуатацию.

При этом большинство респондентов заявили, что не знают, какую конкретно технологию DLC будет рассматривать их предприятие. Эта неопределенность может отражать отсутствие ясности в характеристиках разных платформ из-за малого количества внедрений, что не позволяет предприятиям сформировать более четкое представление о них. У экспертов Uptime сложилось схожее мнение о рынке DLC, который все еще находится в движении: потенциальные клиенты ЦОДов изучают варианты, запускают пилотные проекты и тестируют системы прямого жидкостного охлаждения для сбора данных и накопления опыта эксплуатации.

Источник: Uptime Institute Intelligence

Рис. 6. Популярность систем DLC

Подведем итоги

Прямое жидкостное охлаждение всегда использовалось в охлаждении ИТ-инфраструктуры, но почти исключительно в мейнфреймах и суперкомпьютерах. Было реализовано несколько проектов DLC для ИТ-инфраструктуры общего назначения, но пока это лишь исключение из правила – воздушного охлаждения.

Согласно данным, проанализированным Uptime, сфера применения DLC будет расширяться, поскольку тепловая мощность высокопроизводительных серверных микросхем растет, а их предельные рабочие температуры снижаются. Воздушное охлаждение не сможет работать с этими чипами без серьезных компромиссов, таких как более крупные радиаторы и более высокая мощность вентиляторов или (что еще хуже) без необходимости снижения температуры воздуха. Темпы внедрения DLC в ЦОДах будут в значительной степени определяться спросом на повышение производительности приложений и эффективности инфраструктуры при внедрении процессоров следующего поколения.

Тем не менее, чтобы изменить архитектуру охлаждения в ЦОДах, не нужен полный или массовый переход на DLC. Даже относительно небольшое количество ИТ-систем, для которых необходимо прямое жидкостное охлаждение, может изменить требования к объекту, если ожидается, что они будут работать в сочетании с системами воздушного охлаждения, как это может быть в случае с охлаждающими пластинами и системами с погружным шасси. Например, понадобится поддержка блоков CDU на уровне всего дата-центра. А наличие лишь нескольких систем с погружением в ванну потребует выделенной зоны и дополнительного пространства для обслуживания ИТ-оборудования.

Неопределенность перспектив внедрения DLC усложняет планирование мощности подводимого электропитания. С одной стороны, операторы ЦОДов не хотят слишком быстро исчерпать ресурсы и получить пустоту в машинных залах, с другой – не хотят переплачивать за мощность, которая никогда не будет востребована.

Похоже, что прямое жидкостное охлаждение теперь заинтересует не только тех, кто эксплуатирует высокоплотные ИТ-стойки, но и гораздо более широкую категорию заказчиков, имеющую всего несколько серверов с высокопроизводительными/низкотемпературными компонентами наряду со стандартным ИТ-оборудованием, которое, вероятно, останется на воздушном охлаждении.

Несмотря на то, что распространение DLC точно смоделировать невозможно, эксперты Uptime видят убедительные доказательства общего движения в этом направлении. Растущий спрос на вычислительные ресурсы в сочетании со стремлением снизить затраты на ЦОДы и увеличить экологическую устойчивость также стимулирует внедрение DLC. Однако это внедрение, вероятно, будет сдерживаться раздробленностью рынка поставщиков, недостатком компонентов, организационной инерцией и отсутствием формальных стандартов.

Весьма вероятно, что в ближайшие несколько лет один-два крупных оператора ЦОДов примут стратегические решения использовать DLC в стандартных проектах своих дата-центров следующего поколения. Это может подтолкнуть участников более широкой экосистемы производителей систем охлаждения ЦОДов и ИТ-оборудования увеличить инвестиции в разработку продуктов DLC и их крупносерийное производство, что, в свою очередь, может привести к стандартизации де-факто одного или двух типов технологии прямого жидкостного охлаждения.

Тренды микропроцессорных технологий в сочетании с потребностями бизнеса в повышении производительности и экологичности инфраструктуры указывают на то, что широкое распространение DLC – лишь вопрос времени.

Дэниел Бизо, директор по научно-исследовательской работе, Uptime Institute Intelligence

Ленни Саймон, старший научный сотрудник, Uptime Institute Intelligence

Жаклин Дэвис, аналитик-исследователь, Uptime Institute Intelligence

Публикуется с разрешения Uptime

Institute

Заметили неточность или опечатку в тексте? Выделите её мышкой и нажмите: Ctrl + Enter. Спасибо!