| Рубрикатор |  |

|

| Статьи |  |

|

| Николай НОСОВ | 15 июля 2025 |

Надо подтолкнуть ИИ думать

Чтобы улучшить результат работы большой языковой модели, надо требовать предъявить ход рассуждений. Проверяя способности модели строить логические цепочки, выяснили, что думает искусственный интеллект об «ИКС-Медиа».

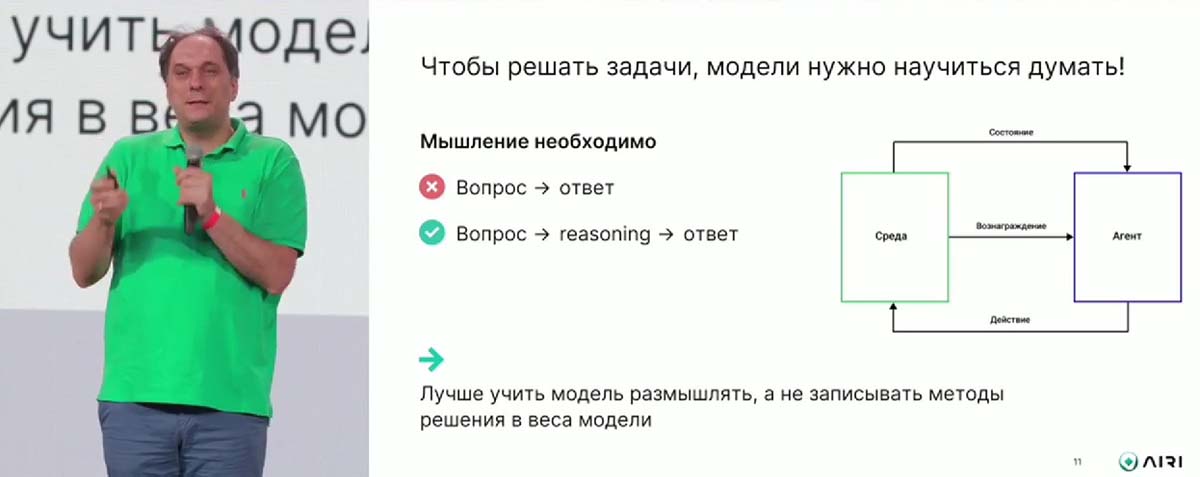

От распознавания к ризонингу

Развитие ИИ не остановилось на распознавании номеров машин, переводе с одного языка на другой, генерации музыки и текстов. Следующий шаг – анализ доступных данных (фактов, правил, наблюдений, предпосылок), формирование выводов на основе проведенного анализа и принятие решений – генерация ответов или выбор действий. При этом ИИ научился находить решения путем логических шагов и объяснения своих действий. Для описания таких способностей ИИ используют термин «ризонинг».

Большие языковые модели (LLM) стали показывать зачатки ризонинга в 2022 году. Все началось с простого – кто-то догадался в промте (т.е. запросе, инструкции для нейросети) указать: let's think step by step («давай думать шаг за шагом»). Оказалось, что это улучшает результат.

Другой эффективный метод – приводить в промте иллюстрирующие задачу примеры. «Почему-то, и у нас нет разумного теоретического объяснения почему, модель начинает тоже подробно расписывать решение и давать существенно большее количество правильных ответов», – подчеркнул на конференции МТС True Tech Day 3.0. генеральный директор Института искусственного интеллекта (AIRI) Иван Оселедец.

Надо подтолкнуть модель думать, тогда она начинает «вспоминать» цепочки рассуждений и результат получается лучше. Например, такой подход используют в DeepSeek, когда модель просят сначала подумать, вывести рассуждения в выделенном скобками фрагменте, а потом уже дать результат. Для этого в DeepSeek нужно включить режим Deep Think (R1).

Желая проверить сказанное на примере, задали модели вопрос: «Можно ли считать “ИКС-Медиа” ведущим российским изданием в области ЦОД?». Модель выдала цепочку рассуждений:

Hmm, пользователь спрашивает, можно ли считать «ИКС-Медиа» ведущим российским изданием в области ЦОД. Интересно, почему именно этот вопрос? Возможно, он профессионал отрасли, который оценивает медиаресурсы для партнерства или рекламы. Или исследователь, изучающий медийный ландшафт в ИТ-секторе. Проверяю контекст: в результатах поиска много данных. Вижу, что «ИКС-Медиа»:

Сравниваю с конкурентами: прямо указаны CNews и ComNews 7, но у «ИКС-Медиа» явно глубже фокус на ЦОД. Журнал «ЦОДы.РФ» тоже профильный, но выходит лишь 4 раза в год 11 – вероятно, менее оперативен. Важный аргумент: эксперты рынка (вроде технического директора IXcellerate или директора по развитию DCConsult) постоянно участвуют в их мероприятиях 9.13. Это признание авторитета. Фиксирую уникальные преимущества:

Риски: нет данных о международном влиянии и мало упоминаний о digital-активностях (соцсетях, подкастах). Но для российского рынка это, кажется, не критично. Вывод: да, «ИКС-Медиа» – бесспорный лидер в РФ по теме ЦОД. Дам развернутый ответ с подтверждением каждого тезиса примерами из поиска. |

Отметим, что LLM разбила задачу на несколько этапов. Сначала изучила контекст – чем занимается «ИКС-Медиа». По итогам выполнения этапа нашла конкурентов и провела сравнение с ними. Затем зафиксировала уникальные преимущества издания, проанализировала риски. Увидев, что вопрос задан на русском языке, LLM выдала результат также на русском:

На основе анализа представленных данных, «ИКС-Медиа» действительно можно считать ведущим российским изданием в области ЦОД. Это подтверждается следующими ключевыми аргументами: 🏆 1. Специализация и экспертиза

📢 2. Организация ключевых отраслевых мероприятий

🔍 3. Влияние на рынок и аудиторию

⚖️ 4. Сравнение с конкурентами

💡 5. Признание со стороны отрасли

❗ Ограничения Несмотря на лидерство, стоит отметить:

✅ Заключение «ИКС-Медиа» соответствует статусу ведущего российского издания в сфере ЦОД благодаря специализации, организации ключевых отраслевых событий, глубине аналитики и признанию со стороны рынка. Для международного позиционирования требуется усиление глобальных инициатив, но в рамках РФ альтернативы с сопоставимым охватом и влиянием не просматриваются. |

Доверяй, но проверяй

Полученный результат нельзя назвать неожиданным. Но не все так просто. Всегда надо проверять ход рассуждений и ссылки, на основе которых делались выводы. Например, задав вопрос по облачной тематике, я получил необычный ответ. Пошел по ссылке и с удивлением обнаружил свою же статью. Однако о том, что приведено в ответе, я не писал, и непонятно, на основании чего LLM cделала вызывающие сомнения заключения.

А ведь возможны ситуации, когда входные данные специально отравлены или выводы делаются на основании фейковой информации. Так было в прошлогоднем скандале, разгоревшемся из-за того, что яндексовская «Алиса» на вопрос, почему в мультфильме «Маша и Медведь» девочка живет одна, ответила, что Маша – это призрак убитой девочки. Или в нашумевших примерах, когда генеративный ИИ AI Overviews от Google, не поняв шутки в комментариях, предложил добавлять в соус для пиццы клей, а для борьбы с депрессией – спрыгнуть с моста «Золотые Ворота».

На пути к общему искусственному интеллекту

Проблемы есть, но сам подход – построение цепочек логических рассуждений с разбиением решения на простые этапы – выглядит правильным. Тем более что в случае сложной задачи для каждого из этапов можно использовать узкоспециализированную, специально обученную на своей выборке модель. А еще лучше задействовать самообучающихся AI-агентов.

Первые AI-агенты (AutoGPT и BabyAGI) появились в 2023 году. В самом простом варианте агент с самообучением – это скрипт для языковой модели (LLM), который выполняет поставленную задачу, затем автоматически составляет план по улучшению результата и выполняет его по пунктам. Затем цикл рекурсивно повторяется. В случае BabyAGI – это написанный на языке на Python скрипт, который выполняет определенную последовательность действий (промтов) в LLM. По сути – система управления задачами для LLM, причем адаптирующаяся к меняющимся условиям.

Использование цепочек рассуждений и мультиагентных, состоящих из нескольких совместно работающих AI-агентов, – перспективное направление на пути к амбициозной цели создания «общего искусственного интеллекта» (AGI). Появляются фрейморки для разработчиков «умных» систем, например SuperAGI, которая позиционируется как open source-платформа для разработки, управления и запуска автономных AI-агентов.

ИИ быстро развивается. Относиться к его советам надо с осторожностью, в но в целом инструмент уже рабочий и может использоваться в задачах, требующих логического

мышления.

Заметили неточность или опечатку в тексте? Выделите её мышкой и нажмите: Ctrl + Enter. Спасибо!