| Рубрикатор |  |

|

| Статьи |  |

|

| 29 января 2019 |

Вычислительные платформы для искусственного интеллекта

Технологии под собирательным названием «искусственный интеллект» уже находят применение в самых разных областях – от гаджетов до мощных аналитических систем. Залог их эффективного использования – «правильная» вычислительная платформа.

Ключевые направления и перспективы ИИ

Ключевые направления и перспективы ИИБизнес начинает рассматривать технологии искусственного интеллекта (ИИ) как средство получения конкурентных преимуществ. Согласно оценкам Gartner, мировой рынок ИИ по итогам 2018 г. достиг объема $1,2 трлн, что на 70% превышает показатели 2017 г. В России годовой объем рынка ИИ и машинного обучения в 2017 г. оценивался отраслевыми экспертами примерно в 700 млн руб. К 2020 г. он может вырасти до 28 млрд руб. Некоторые специалисты уверены, что в ближайшие несколько лет этот сегмент превысит 50 млрд руб.

По прогнозу Frost & Sullivan, к 2022 году объем мирового рынка технологий ИИ увеличится до $52,5 млрд при ежегодных темпах роста 31%. Основные направления инвестиций – платформы машинного обучения и компьютерного зрения, приложения машинного обучения, а также роботы, виртуальные помощники и распознавание видеоизображений (рис. 1).

Опросы Forrester свидетельствуют, что в мире более половины компаний уже внедрили или расширяют внедрение ИИ и еще 20% планируют реализовать эти технологии в течение ближайшего года. В России, по информации «АйПи Лаборатории», чаще всего искусственный интеллект применяют для бизнес-аналитики и других подобных задач в сфере B2B. В число наиболее популярных областей использования ИИ также входят компьютерное зрение, системы здравоохранения и различные NLP-системы обработки естественного языка -- от распознавания голоса до чат-ботов.

По прогнозам аналитиков, к 2025 г. свыше 86% предприятий и организаций в мире станут применять в своей работе ИИ, а 80% данных будут реально использоваться, а не просто храниться в архивах. ИИ проникнет во все сферы деятельности любого крупного предприятия. Это позволит увеличить прибыль благодаря предиктивной аналитике и выявлению тенденций, повысить продуктивность и уровень информационной безопасности за счет глубокого анализа данных, улучшить качество обслуживания клиентов и, наконец, высвободить сотрудников для решения задач более высокого уровня. Поэтому предприятия изучают возможности извлечения ценной информации из имеющихся данных, и это вызывает потребность в подходящих для подобных задач вычислительных мощностях. Пытаясь воплотить обещанные ИИ возможности в реальность, компании сталкиваются с проблемой выбора пригодных для их целей платформ.

Новая эра вычислений

Большое значение для получения ценных для бизнеса результатов с помощью ИИ имеет инфраструктура серверов, ускорителей вычислений, сетевых фабрик и систем хранения данных, а также ПО. Для решения многих задач ИИ требуются платформы, способные обеспечить высокопроизводительные вычисления и обладающие быстрой памятью большого объема для работы с многопетабайтными наборами данных.

Нехватка специализированных платформ и процессорных мощностей в значительной степени тормозит развитие технологий ИИ, из-за этого соответствующие математические модели приходится упрощать.

Использовать для ИИ стандартный процессор х86 часто нецелесообразно, приложения ИИ зачастую работают на базе совершенно других архитектур. Больше для таких задач пригодны системы с конвейерной архитектурой процессоров и массивным параллелизмом. Именно поэтому многие производители, стремясь оптимизировать вычисления для искусственного интеллекта, обращаются к графическим процессорам (GPU). Для рабочих нагрузок ИИ создаются специализированные системы, включающие центральные и графические процессоры, устройства памяти и хранения данных.

Так, AMD представила недавно созданный по 7-нм техпроцессу графический процессор на базе чипов Vega. Этот процессор имеет площадь всего 331 кв. мм, но на ней разместилось 13,23 млрд транзисторов. Для связи между графическими процессорами используется шина Infinity Fabric с пропускной способностью 100 Гбайт/с на канал.

Создаваемые разработчиками процессоров продукты позволяют предлагать более доступные по цене платформы ИИ и обходиться без заказных специализированных микросхем. В настоящее время поддержка технологий ИИ и машинного обучения заняла прочное место в стратегиях производителей процессоров и поставщиков инфраструктурных ИТ-решений.

Объемная компоновка для высокопроизводительной логики

В декабре 2018 г. Intel представила свою стратегию, в которой искусственный интеллект стал одним из ключевых направлений. Так, энергонезависимая память Intel Optane DC с производительностью, близкой к скорости работы оперативной памяти, позволит ускорить обработку больших наборов данных в задачах ИИ. Как ожидается, средняя задержка чтения из памяти Optane DC достигнет примерно 350 нс. Для сравнения: у твердотельных накопителей Optane DC SSD эта величина составляет порядка 10 мкс.

А новая технология 3D-микросхем Foveros даст возможность применить многоярусную компоновку кристаллов в корпусе в отношении высокопроизводительной логики, например при создании процессоров для задач ИИ. Разработчики смогут комбинировать фрагменты сложных функциональных блоков с различными элементами памяти и ввода-вывода в новых формфакторах. При этом подсистема ввода-вывода, память SRAM и цепи питания могут быть выполнены в базовом кристалле, а чиплеты с высокопроизводительной логикой размещаться поверх него. Согласно планам Intel, новые продукты на базе Foveros будут представлены во второй половине 2019 г.

Корпорация также подтвердила планы выпуска к 2020 г дискретного графического процессора, а пока представила новую интегрированную графику Gen11. Она появится в процессорах, созданных по 10-нм техпроцессу, уже в текущем году. Gen11 призвана практически удвоить скорость выполнения задач ИИ в наиболее распространенных сценариях работы обученных моделей на основе нейронных сетей, например при распознавании изображений.

Большое внимание уделяется и разработке ПО. Анонсированный Intel интерфейс One API должен упростить программирование для CPU, GPU, FPGA и ускорителей ИИ. Разработчики получат инструменты для оптимизации кода. Релиз намечен на 2019 г. Еще одна новинка -- интегрированный высокопроизводительный стек глубокого обучения Deep Learning Reference Stack с открытым исходным кодом. Он оптимизирован для платформ Intel Xeon Scalable и должен обеспечить разработчикам удобный доступ к их функциям. Стек специально создавался и оптимизировался для нативных облачных окружений. Он упростит интеграцию различных программных компонентов, что позволит разработчикам ускорить прототипирование, сохранив достаточную гибкость для индивидуальной настройки решений.

От графических процессоров – к платформам

Для решения задач из разных областей, требующих высокопроизводительных вычислений, будь то майнинг, искусственный интеллект, обработка видео и пр., предназначает свои продукты NVIDIA. Они строятся на единой архитектуре и проектируются таким образом, чтобы было удобно программировать и неграфические задачи. Однако для задач ИИ компания предлагает не просто графические процессоры или платы, а целостную платформу. Это комплекс, в который входят графические процессоры и ПО. NVIDIA разрабатывает часть ПО сама, а также оптимизирует фреймворки Google, Microsoft, Amazon и др.

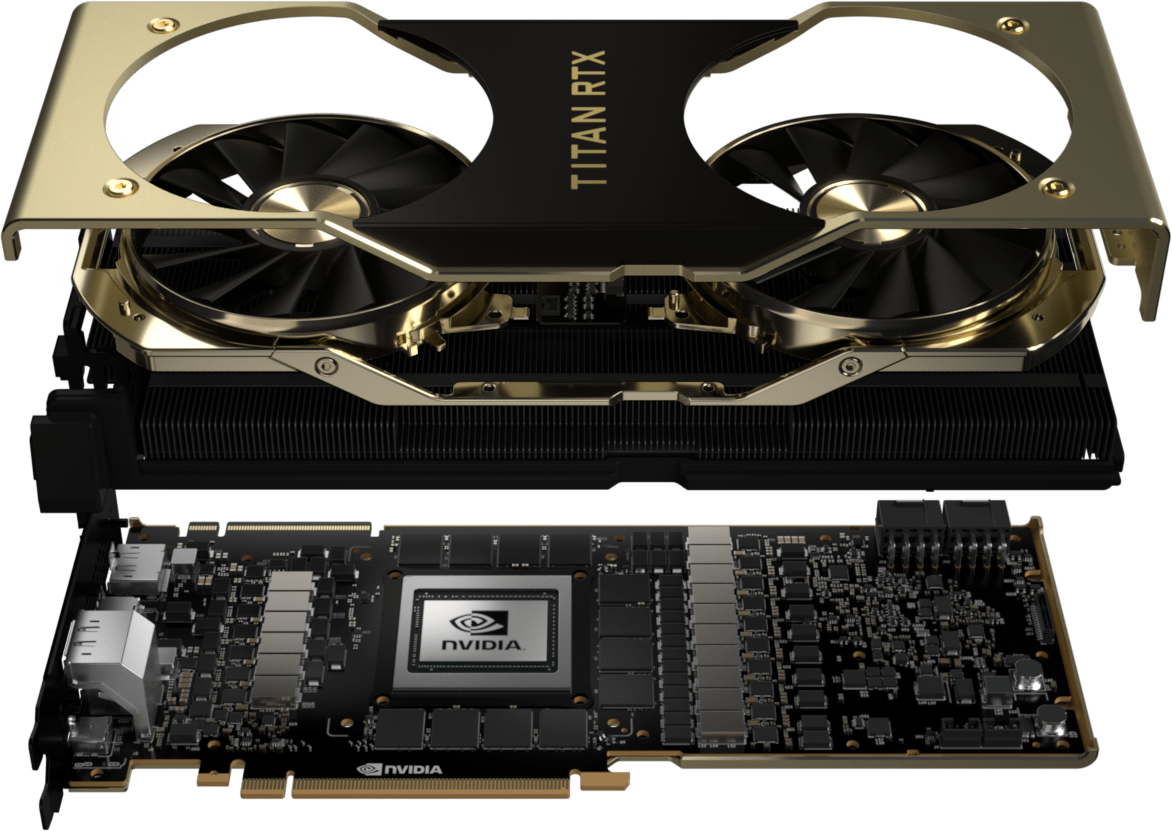

В декабре 2018 г. NVIDIA представила Titan RTX – графический процессор с 576 тензорными ядрами для исследований в области ИИ и анализа данных (рис. 2). Его производительность в операциях глубокого обучения -- 130 Тфлопс. 24 Гбайт высокоскоростной памяти GDDR6 с полосой пропускания 672 Гбайт/с позволяют работать с крупными моделями и наборами данных. Интерфейс NVIDIA NVLink 100 Гбайт/с для объединения двух GPU Titan RTX дает возможность достигать еще более высокой производительности. Titan RTX ускоряет анализ данных и машинное обучение помощью библиотек с открытым кодом NVIDIA Rapids.

В декабре NVIDIA установила несколько новых рекордов по скорости вычислений в задачах, связанных с ИИ. Ее решения показали лучшую производительность в шести тестах MLPerf, охватывающих различные нагрузки и масштаб систем: от 16 GPU на узел до 640 GPU на 80 узлов. Высокие показатели получены в тестах на классификацию изображений, сегментацию объектов, распознавание объектов, нерекуррентный и рекуррентный перевод, системы рекомендаций. Ключевой результат достигнут в категории языкового перевода – на обучение нейросети Transformer ушло всего за 6,2 мин. Инженеры компании получили эти результаты на системах NVIDIA DGX.

Серверы NVIDIA DGX-1 содержат до восьми графических процессоров NVIDIA Tesla V100 Tensor Core с полным интерконнектом с гибридной ячеистой топологией. По данным вендора, каждый сервер DGX-1 может обеспечить в задачах ИИ производительность 1 Пфлопс. Он работает с программным стеком DGX, который включает в себя оптимизированные для платформы NVIDIA версии популярных систем глубокого обучения. Это позволяет достигать в задачах машинного обучения максимальной производительности.

Мощности GPU с тензорными ядрами доступны не только в облаках и дата-центрах, но и в настольных ПК на базе видеокарт NVIDIA Titan RTX. Организациям, локально разворачивающим ИИ-инфраструктуру, внедрить ИИ помогут системы NVIDIA DGX и NGC Ready от Atos, Cisco, Cray, Dell EMC, HP, HPE, Inspur, Lenovo, Sugon и Supermicro.

Последователи и конкуренты

Разработками NVIDIA воспользовались ведущие вендоры. Компания Dell EMC построила универсальную масштабируемую платформу для задач ИИ на базе серверов PowerEdge C-Series с графическими процессорами Tesla V100 Tensor Core от NVIDIA, поддерживающую до нескольких сотен GPU на кластер. Упростить реализацию инициатив в области глубокого обучения и ИИ должна также валидированная платформа и эталонная архитектура Dell EMC Ready Solutions for AI: Deep Learning with NVIDIA с хранилищем Dell EMC Isilon All-Flash (рис. 3) и серверами NVIDIA DGX-1 (по восемь графических процессоров NVIDIA Tesla V100 Tensor Core в каждом).

Флеш-массив Isilon All-Flash Scale-Out NAS имеет емкость до 33 Пбайт и пропускную способность до 540 Гбайт/с. Он поддерживает высокий уровень параллелизма для устранения узких мест в подсистеме ввода-вывода и ускорения рабочих нагрузок ИИ.

Компания NetApp в августе 2018 г. представила NetApp ONTAP AI -- архитектуру систем искусственного интеллекта, работающую на серверах NVIDIA DGX и флеш-массивах NetApp AFF A800. Она призвана ускорить и масштабировать передачу данных в облаке и вне его, упрощая внедрение систем глубокого обучения и помогая заказчикам использовать ИИ, получая при этом ожидаемую производительность.

Решения NetApp для подключения к облаку и новая архитектура с NVIDIA DGX создают единую среду данных для осуществления проектов ИИ. Они обеспечивают контроль над данными и доступ к ним в различных форматах, а также производительность, необходимую для получения приложениями искусственного интеллекта нужных данных.

Достаточно давно занимается развитием искусственного интеллекта компания Huawei. В октябре 2018 г. Huawei представила процессоры серии Ascend, оптимизированные для задач ИИ. Разработчики компании пошли по пути перекладывания решения отдельных задач на специализированные чипы, что должно обеспечивать более эффективное выполнение.

В линейке Ascend пока два процессора. Ascend 310 создан по технологии 12 нм и уже доступен на рынке. Выпуск Ascend 910 запланирован на второй квартал 2019 г. Как сообщается, он создается по технологии 7 нм и будет конкурировать с NVIDIA Tesla V100, обладая более высокой производительностью -- 256 Тфлопс против 125 у V100. Серверы Huawei с новыми процессорами появятся в России в 2019 г. Они могут быть востребованы в финансовом секторе и в интернет-сегменте.

Huawei также анонсировала программно-аппаратную вычислительную платформу Atlas для ускоренной обработки рабочих нагрузок, связанных с ИИ. Она включает модули и устройства для создания инфраструктуры, в частности, модуль ускорителя Atlas 200 AI, карту ускорителя Atlas 300 AI (для дата-центров и периферийных серверов), периферийную станцию Atlas 500 AI и платформу Atlas 800 AI (рис. 4). Huawei Atlas 800 AI использует предустановленную базовую библиотеку программ, включает ПО управления кластером и планирования заданий, а также средства контроля производительности. Такое инфраструктурное решение может применяться в широком спектре сценариев.

Компания также выпустила набор инструментов с открытым исходным кодом на своей облачной платформе, которые помогут разработчикам упростить создание решений ИИ -- от моделей машинного обучения до развертывания систем на локальных устройствах. Инструменты будут доступны на сервисной платформе ИИ Huawei Cloud Enterprise Intelligence. Их можно будет применять и для ее движка для интеллектуальных устройств HiAI.

Новый фреймворк Huawei MindSpore на основе унифицированной распределенной архитектуры для машинного обучения поддерживает модели, обученные на других платформах, таких как TensorFlow и PyTorch, а также предоставляет гибкие API-интерфейсы.

Кроме того, Huawei анонсировала CANN -- вычислительную архитектуру для нейронных сетей с инструментарием разработки Tensor Engine, который обеспечивает автоматическую генерацию, настройку и оптимизацию кода. CANN также включает в себя комплексный оптимизирующий компилятор для задач глубокого обучения. По данным Huawei, CANN может утроить эффективность разработки.

Самооптимизирующаяся ИТ-инфраструктура

Компания HPE перешла к использованию возможностей ИИ для управления ИТ-инфраструктурой в своих системах. В ноябре 2018 г. HPE представила усовершенствования платформы искусственного интеллекта для дата-центров HPE InfoSight, а также устройства HPE Memory-Driven Flash – новый тип корпоративных систем хранения, построенный на памяти Storage Class Memory и интерфейсах Non-Volatile Memory Express (NVMe).

Системы хранения, управляемые ИИ, позволяют создать самооптимизирующуюся ИТ-инфраструктуру. Так, HPE разработала интеллектуальные решения для хранения данных, которые адаптируются и самонастраиваются в режиме реального времени, перемещают данные таким образом, чтобы оптимизировать «экономику хранения».

В HPE InfoSight задача ИИ -- предсказание и предотвращение проблем, а также создание базы для автоматической настройки оборудования в зависимости от меняющихся рабочих нагрузок. По данным HPE, за счет такой самоуправляемой и самооптимизирующейся ИТ-инфраструктуры можно сократить операционные расходы почти на 80%.

HPE Nimble Storage использует рекомендации HPE InfoSight для уровня виртуальных машин. По данным HPE, ИИ InfoSight выходит за рамки базовых инструментов предиктивной аналитики и дает советы по управлению инфраструктурой ИТ, подсказывает, как оптимизировать среду, где лучше разместить данные. Планировщик ресурсов помогает распределять рабочие нагрузки между имеющимися системами хранения.

ИИ как услуга

Технологии ИИ доступны сегодня и в виде облачных сервисов, таких как Amazon Machine Learning (Amazon Comprehend, Amazon Translate и Amazon Lex), Diagflow (принадлежащий Google сервис для расширения приложений с помощью интеллектуальных голосовых и текстовых диалоговых интерфейсов), Machine Learning Studio от Microsoft Azure, поддерживающие создание приложений ИИ, универсальная платформа MonkeyLearn, многим известный IBM Watson и целый ряд других.

В России одни компании еще определяются со стратегией в отношении новой технологии, другие на деле успели опробовать возможности систем ИИ. Например, в сфере финансов эти технологии помогают выявлять случаи мошенничества, в промышленности -- экономят потребление ресурсов, оптимизируют режимы работы оборудования, предсказывают появление брака. В ритейле «умные» системы способны предсказывать, какой товар в тот или иной момент будет пользоваться повышенным спросом. Технологии ИИ находят применение в беспилотных автомобилях, поиске оптимальных маршрутов, общении с клиентами, распознавании речи, оценке платежеспособности клиентов и партнеров и пр. Уже в ближайшие пять лет многим компаниям придется менять свою бизнес-модель, чтобы сохранить конкурентоспособность в условиях быстрого развития ИИ.

Заметили неточность или опечатку в тексте? Выделите её мышкой и нажмите: Ctrl + Enter. Спасибо!